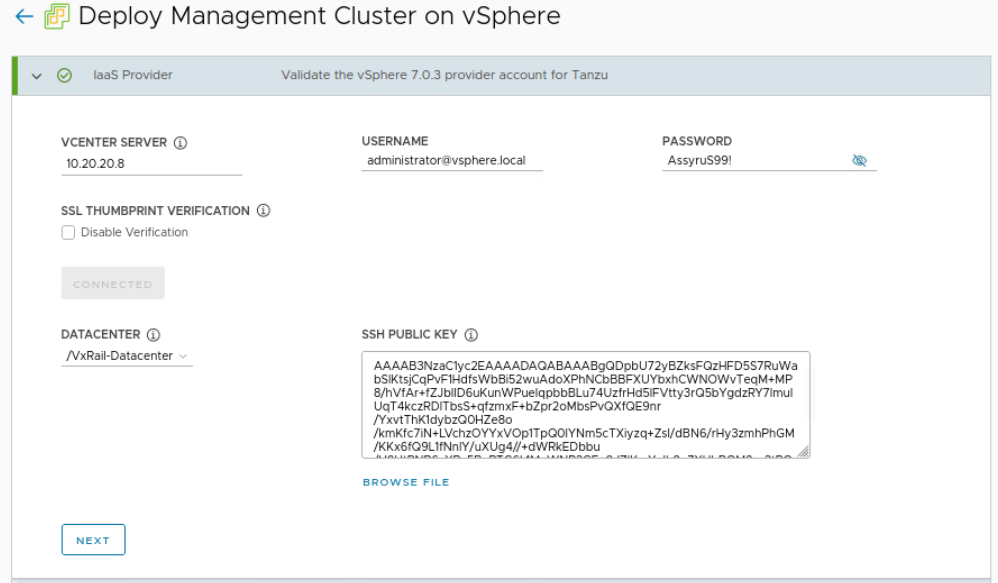

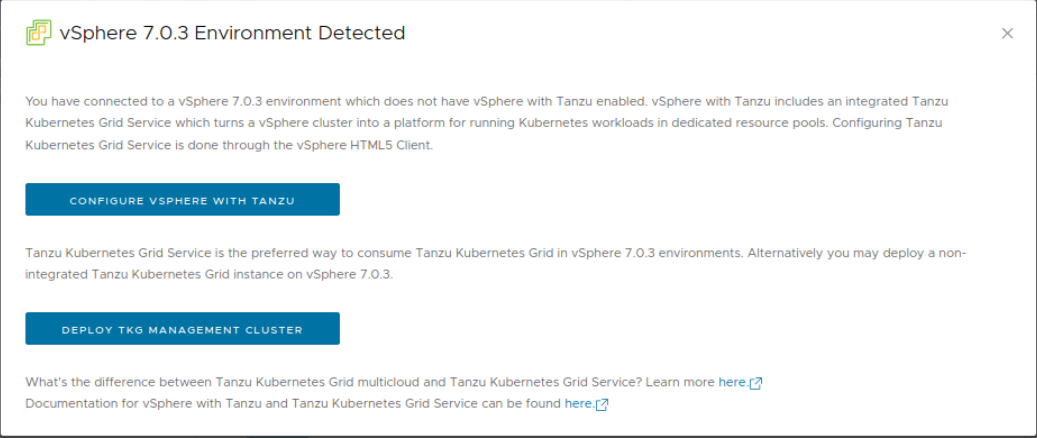

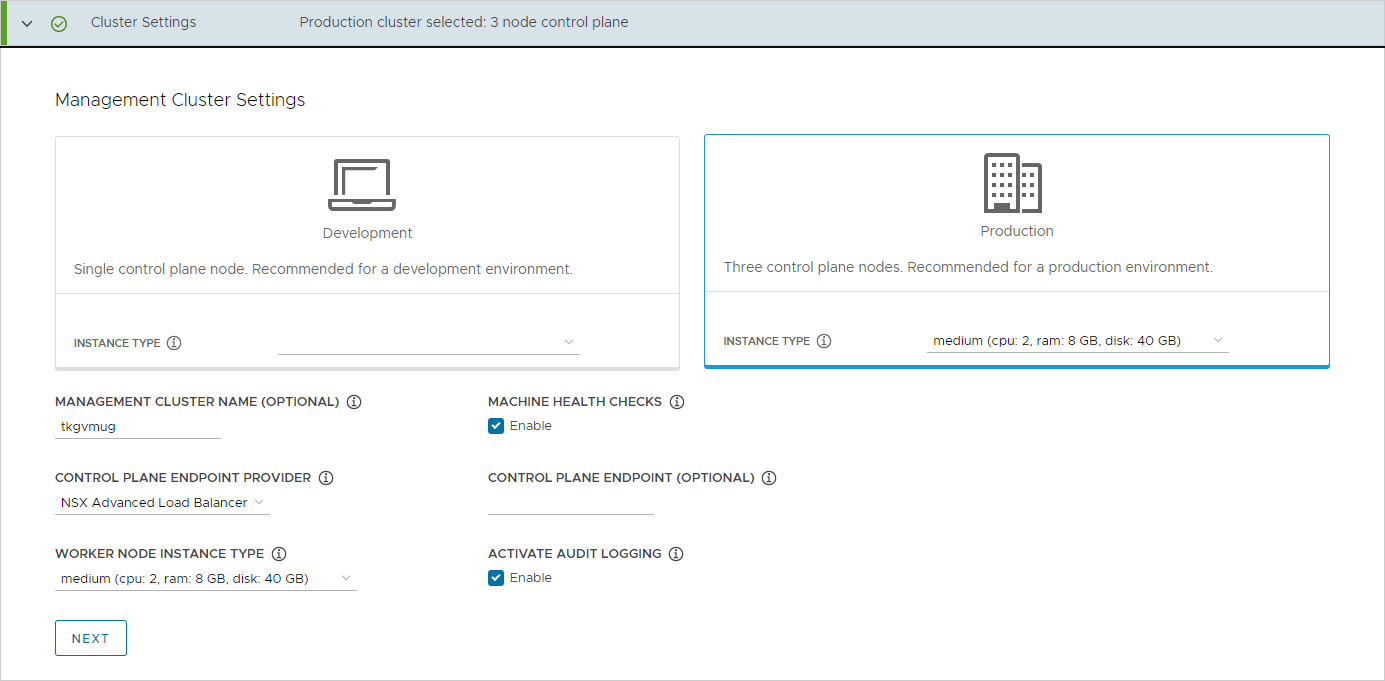

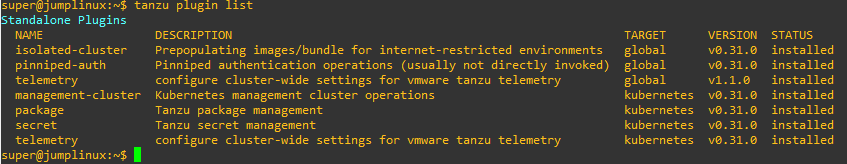

Negli articoli precedenti abbiamo visto come creare un cluster TKG standalone utilizzando NSX ALB come bilanciatore, vediamo come installarlo e configurarlo per TKG.

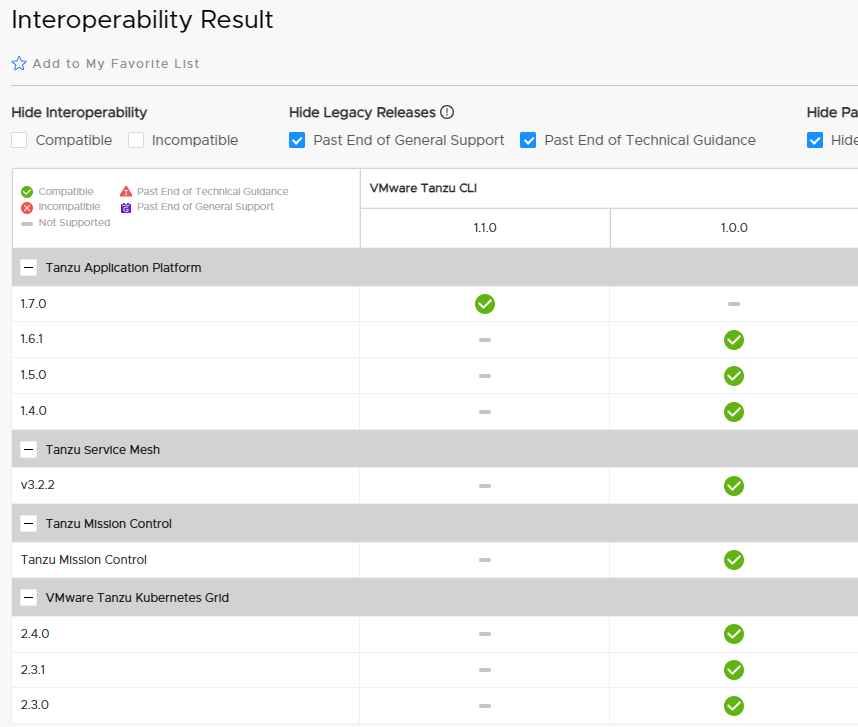

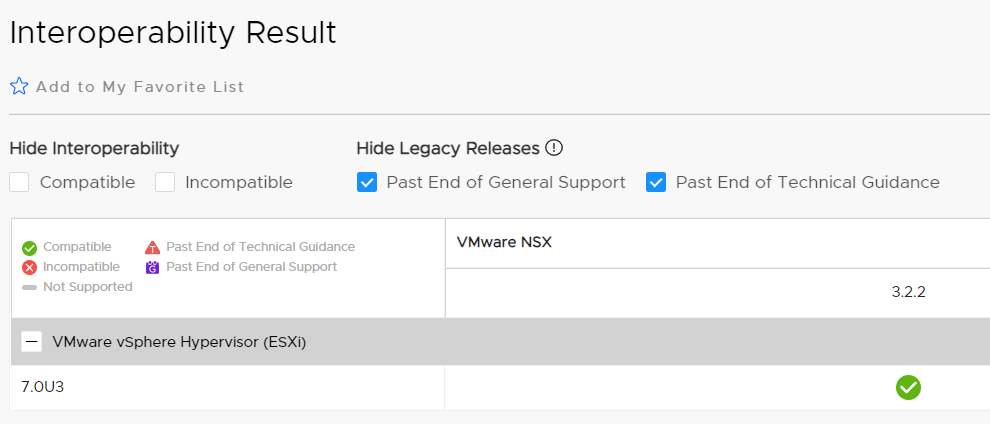

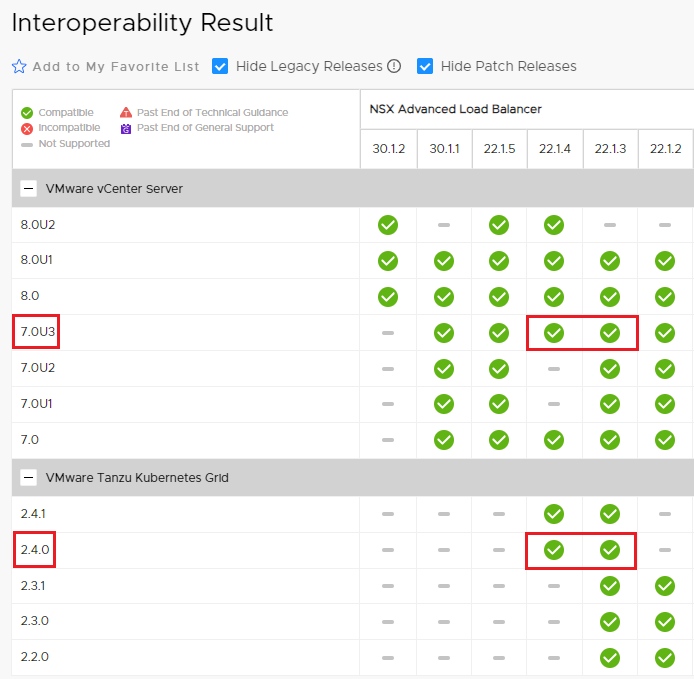

Per prima cosa è necessario verificare quale versione è in matrice di compatibilità con la versione di vSphere e TKG che utilizziamo.

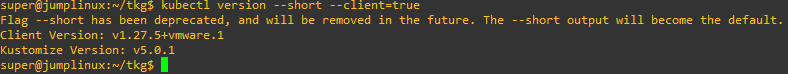

Nel mio caso ho utilizzato vSphere 7.0u3 e TKG 2.4

La verifica è necessaria perchè non tutte le release di ALB sono compatibili con vSphere e TKG, vediamo nel dettaglio la matrice per le versioni che ho utilizzato.

La Matrice di interoperabilità dei prodotti VMware è disponibile a questo link.

La Matrice di interoperabilità dei prodotti VMware è disponibile a questo link.

Le versioni di ALB utilizzabili sono la 22.1.4 e 22.1.3, ho scelto la più recente.

Alla release 22.1.4 andranno applicate anche le ultime patch.

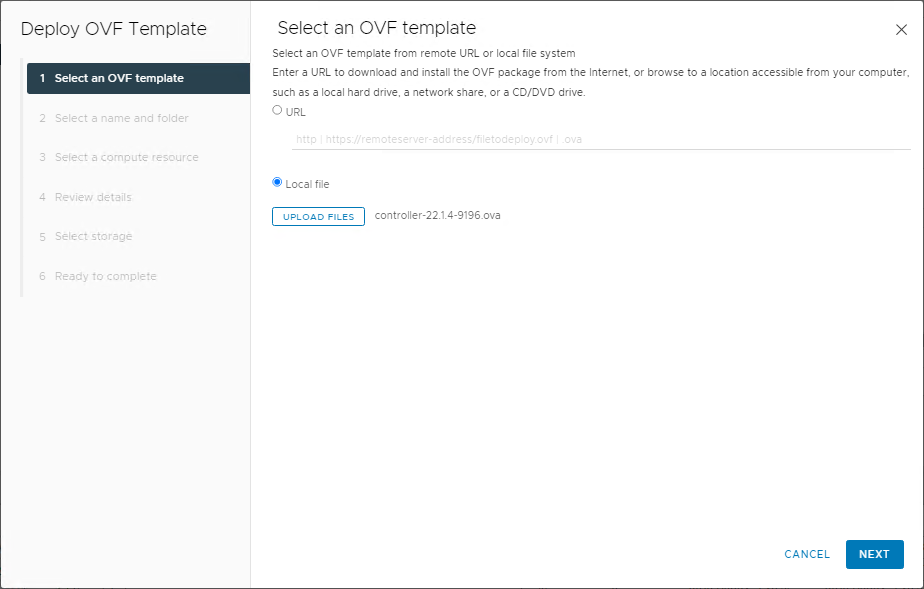

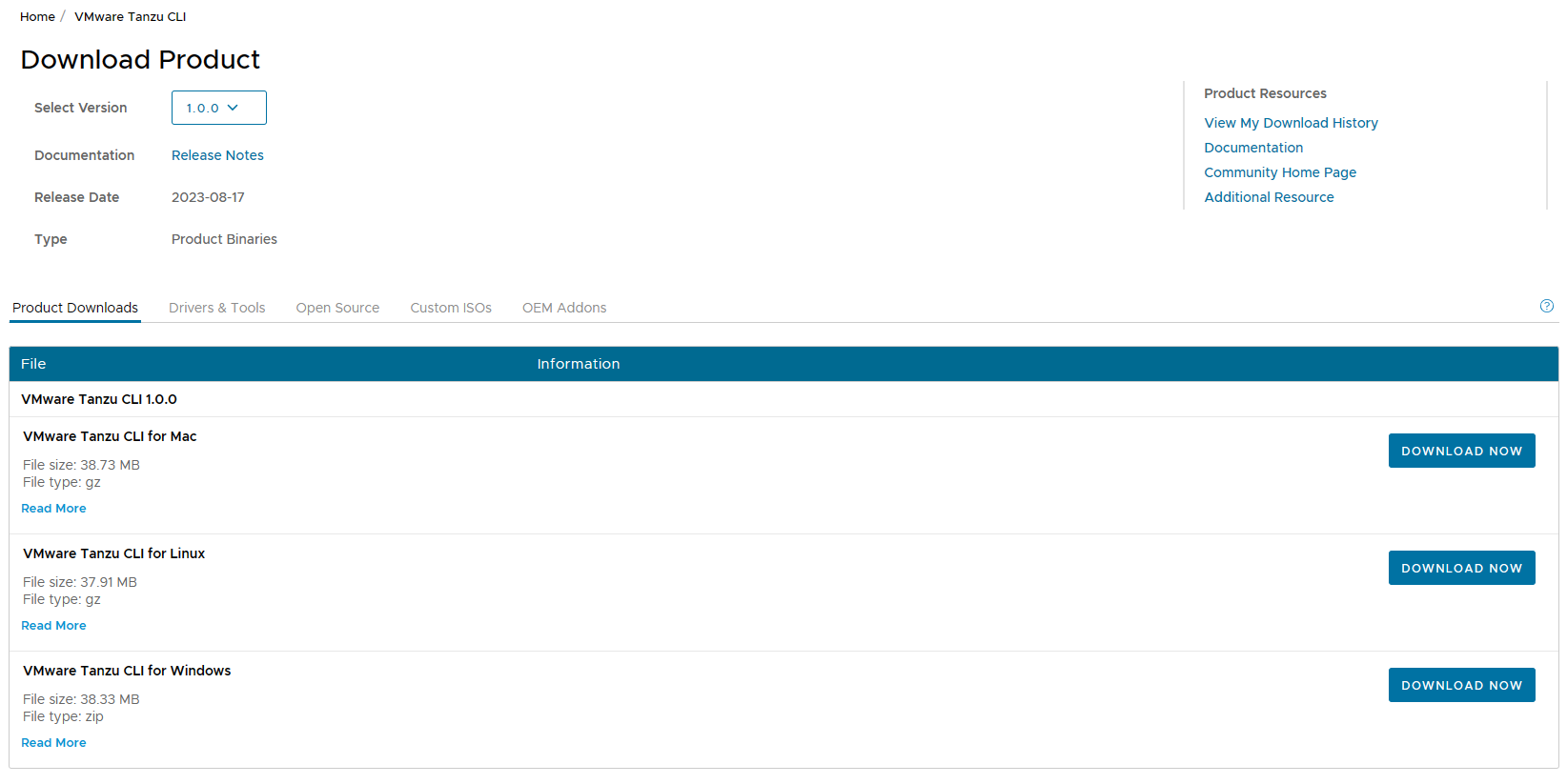

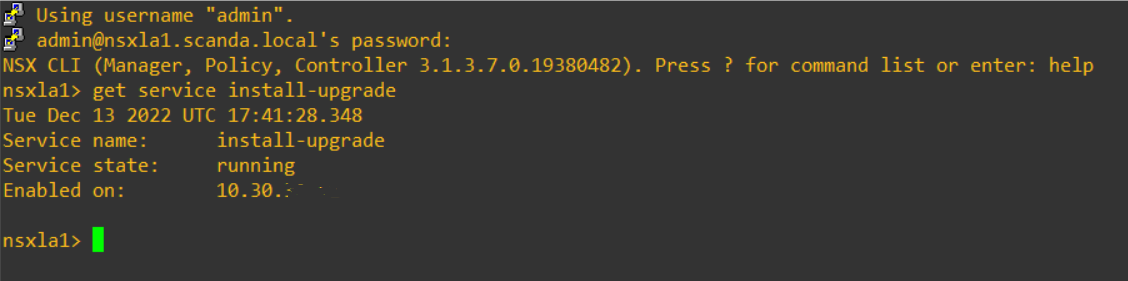

I file da scaricare dal sito VMware sono i seguenti :

controller-22.1.4-9196.ova + avi_patch-22.1.4-2p6-9007.pkg

NOTA: Prima di iniziare il deploy dell’OVA verificate di aver creato i record DNS (A+PTR) per i controller e il VIP del cluster.

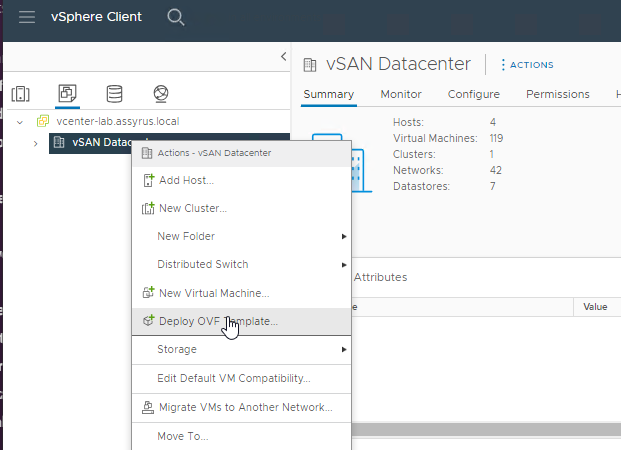

Iniziamo il deploy del controller sul nostro cluster vSphere.

Selezioniamo il file OVA

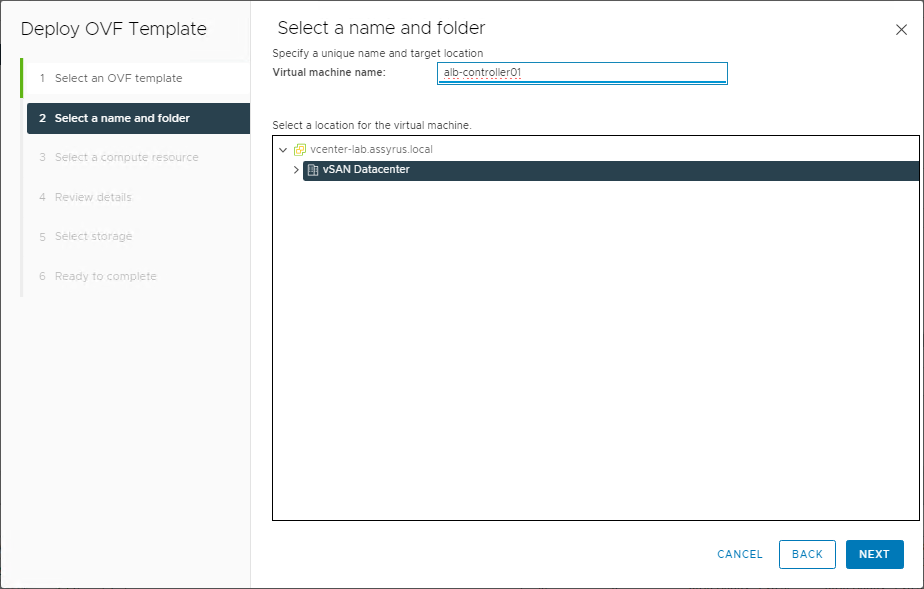

Diamo il nome alla VM e selezioniamo il Datacenter e il Cluster di destinazione

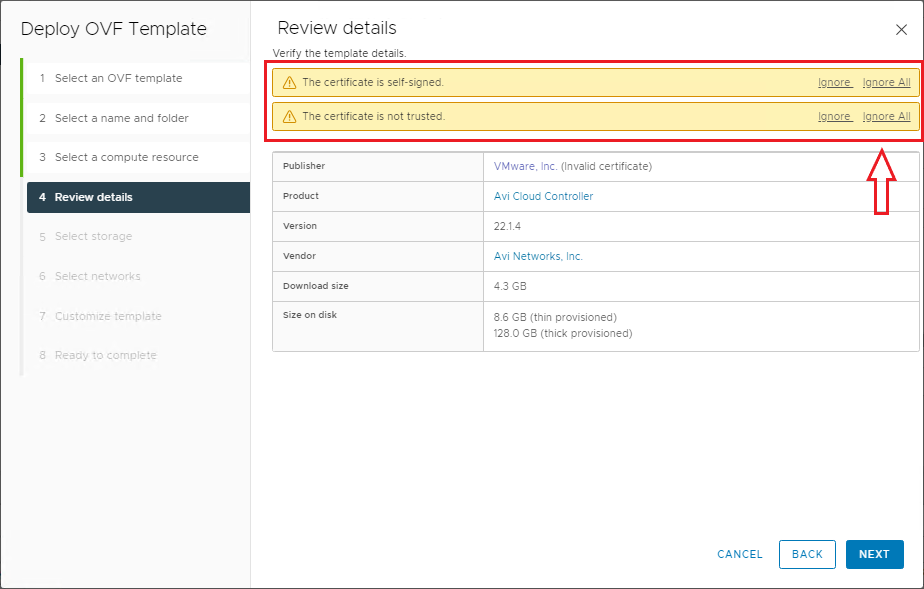

Al riepilogo ignorare i warning sul certificato, next

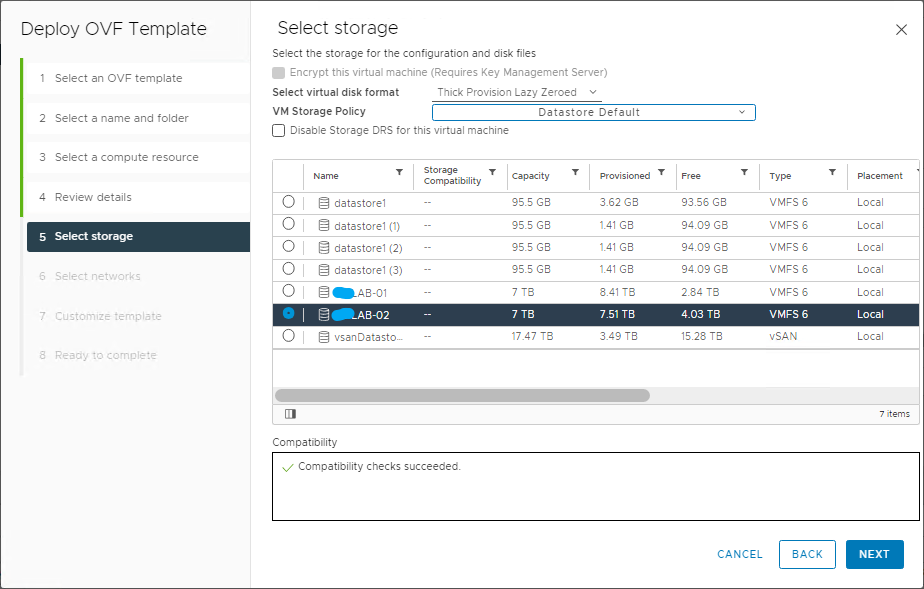

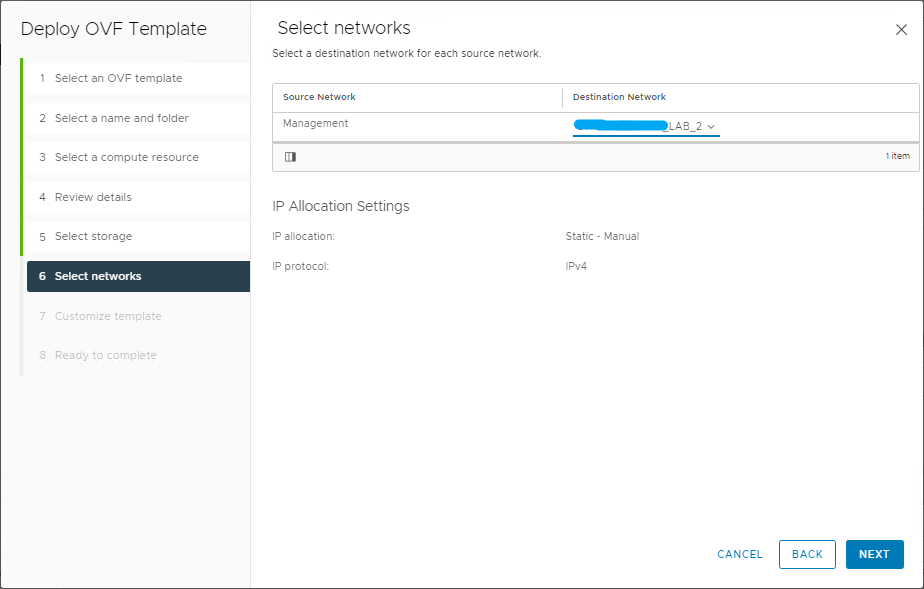

Nei prossimi passi selezionare il datastore e la network di management del controller

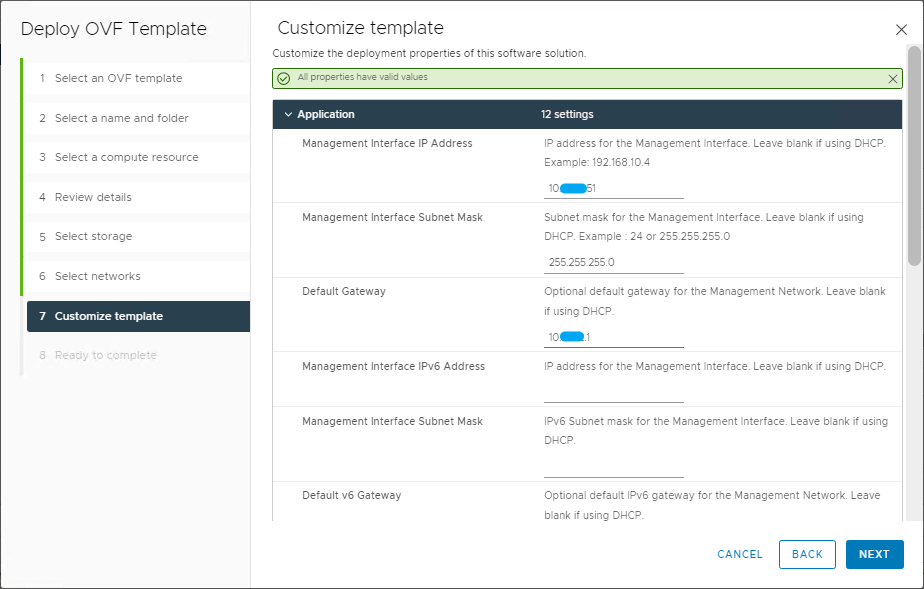

Inserire ora le impostazioni per l’interfaccia di management del controller

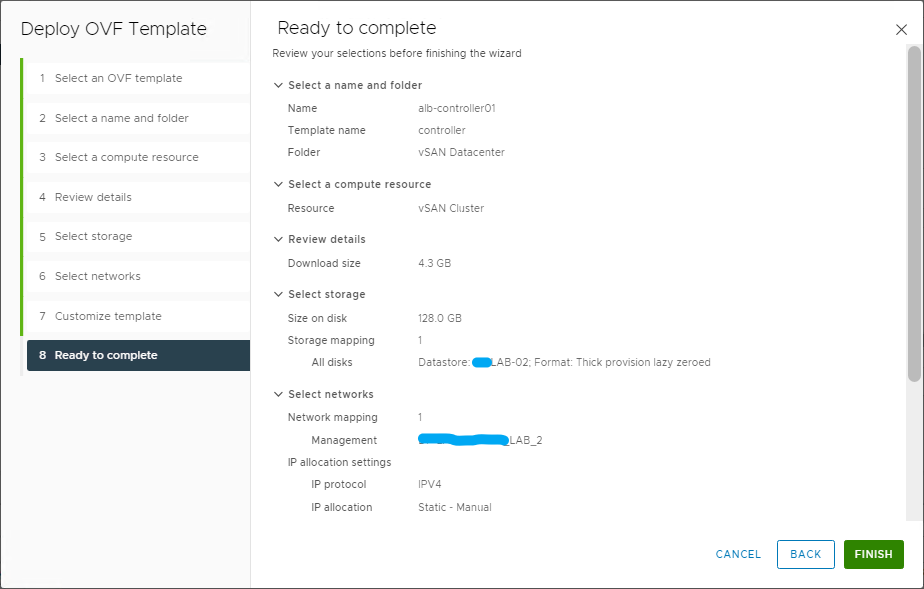

Al riepilogo selezioniamo FINISH per avviare il deploy

Accendiamo la VM e attendiamo che i servizi siano attivi (richiede un pò di tempo)

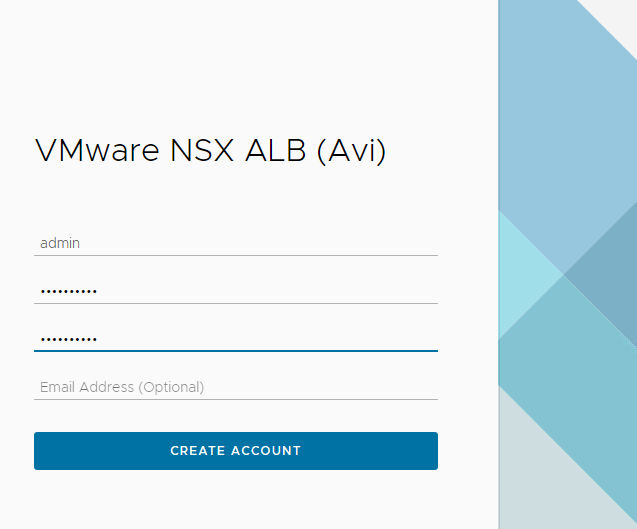

Al primo accesso sarà necessario inserire la password dell’utente admin

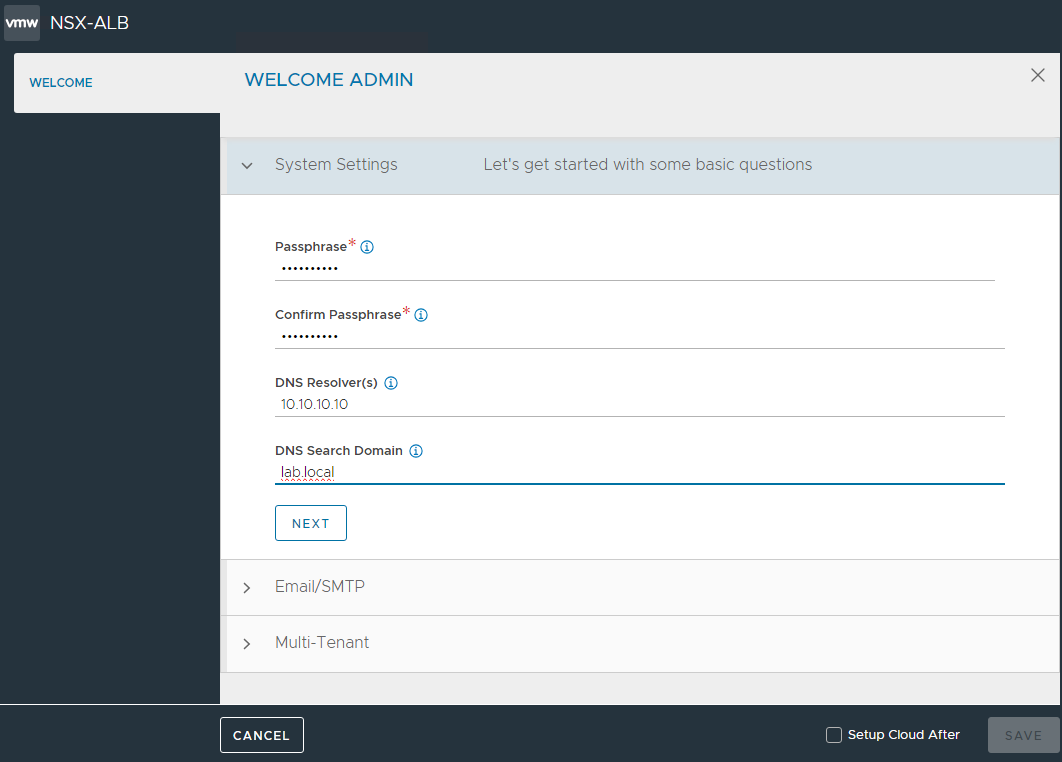

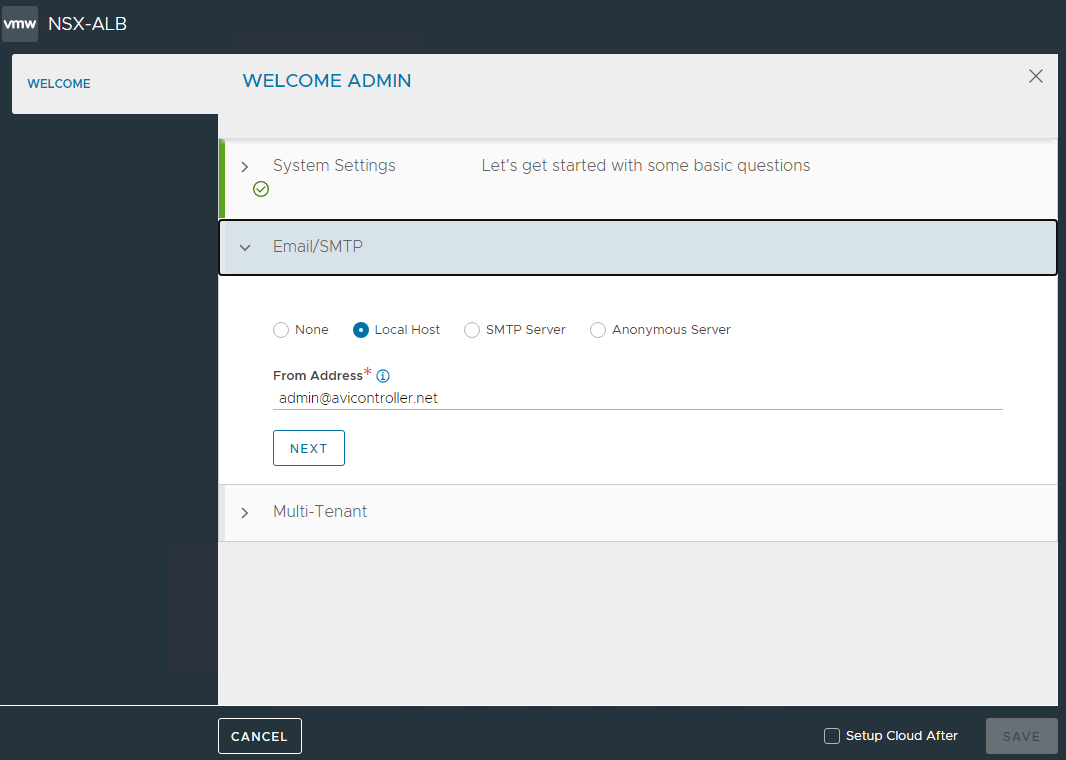

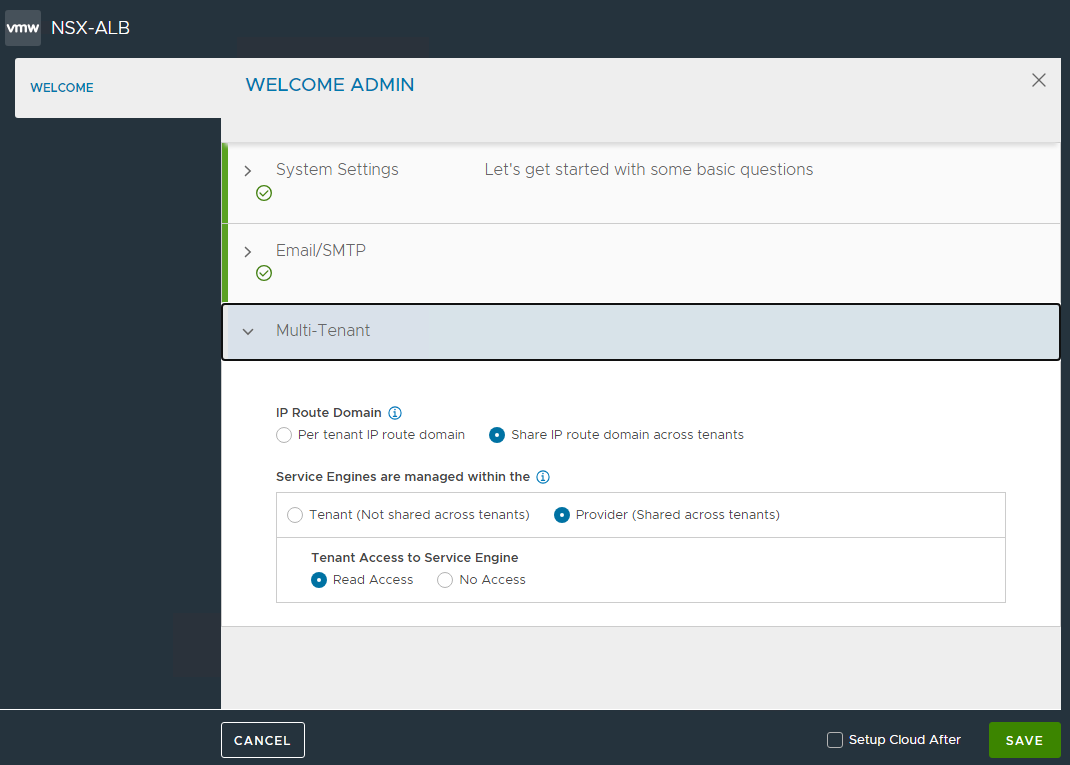

Inserire le informazioni necessarie a concludere la configurazione con SAVE

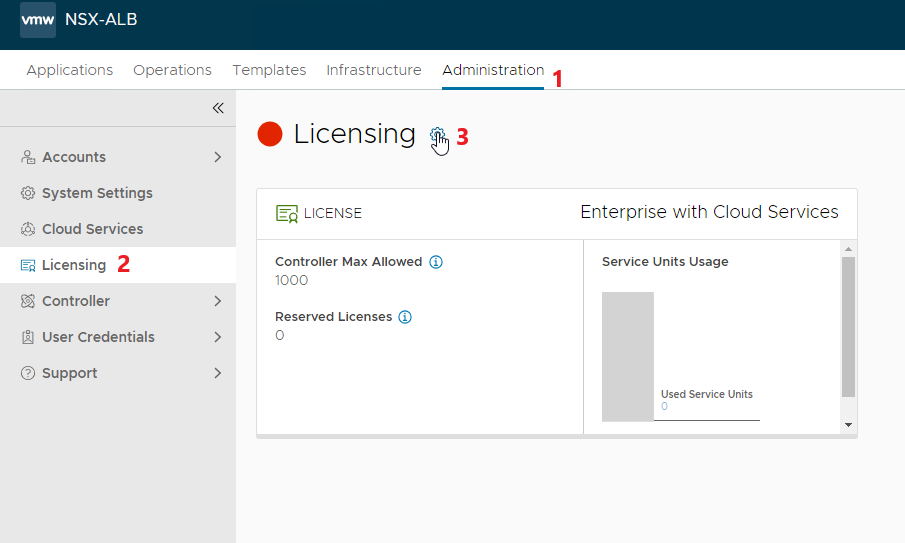

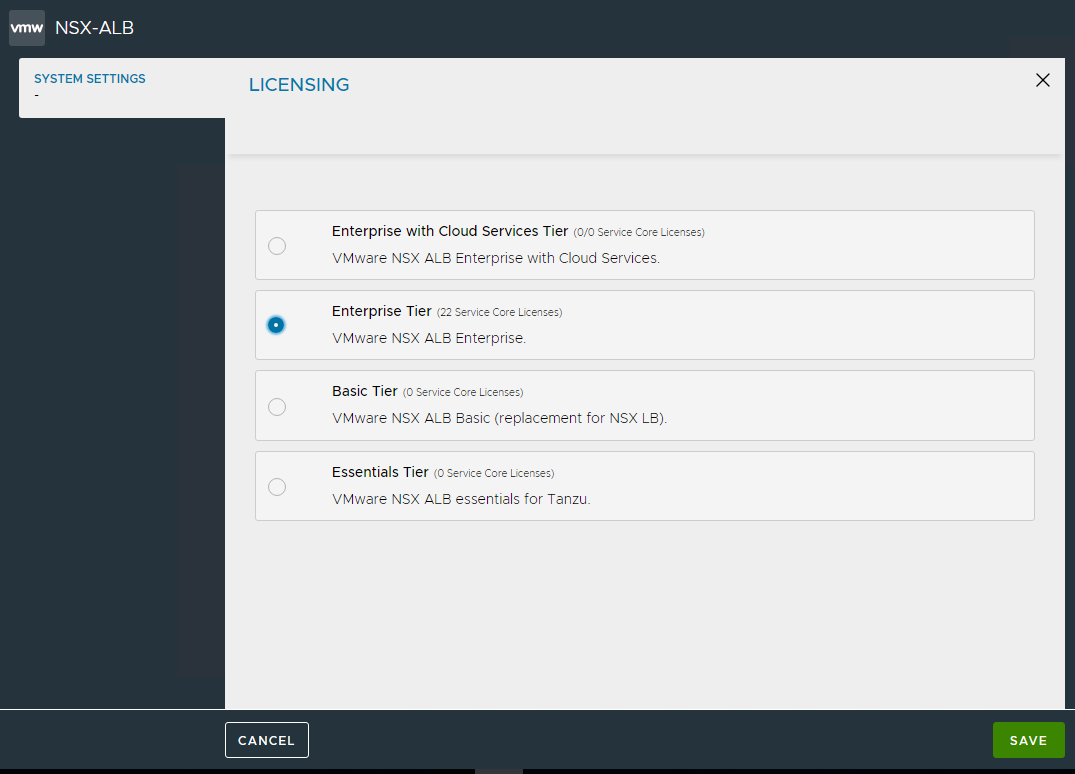

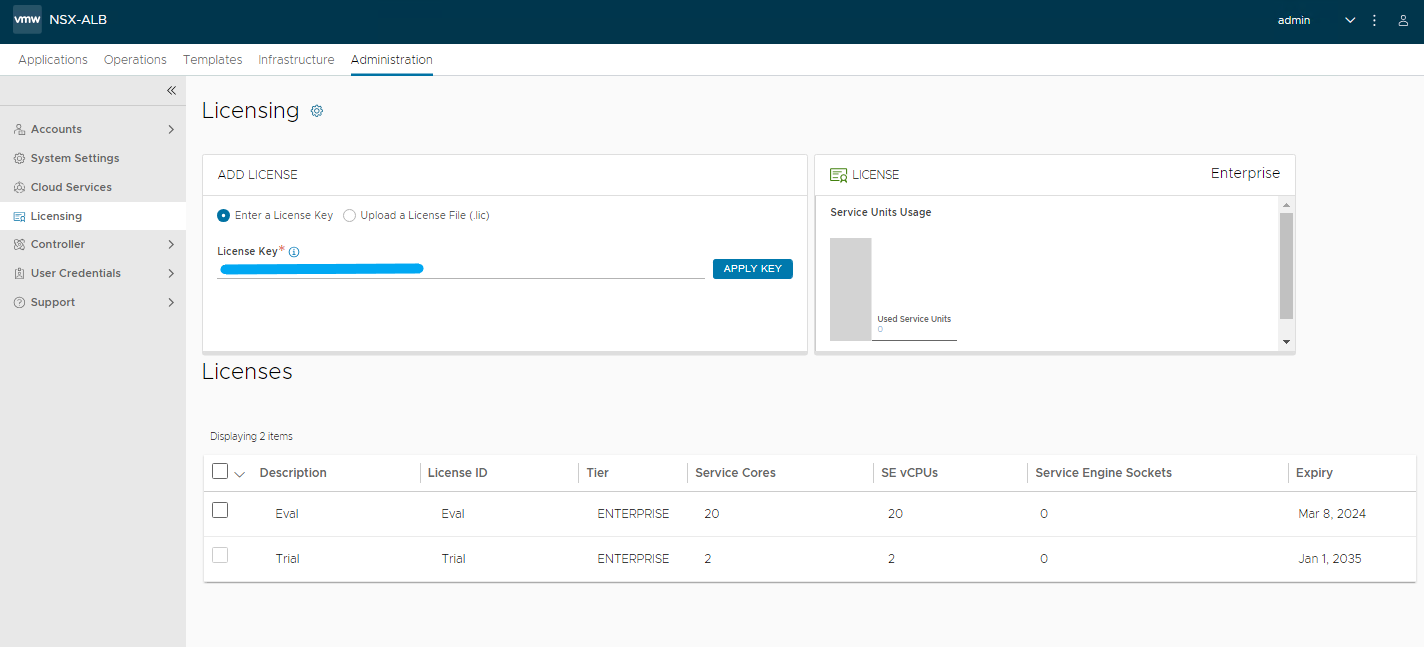

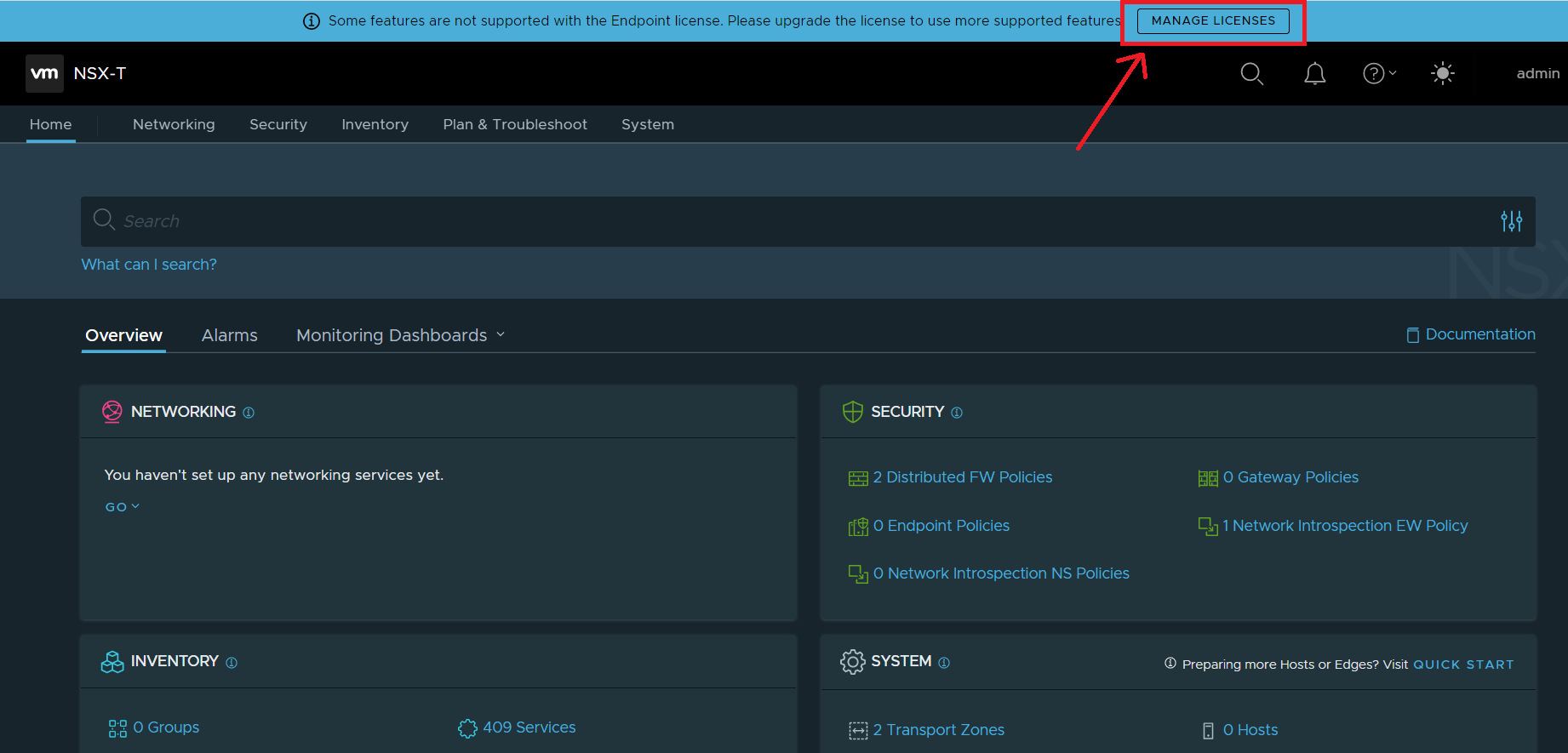

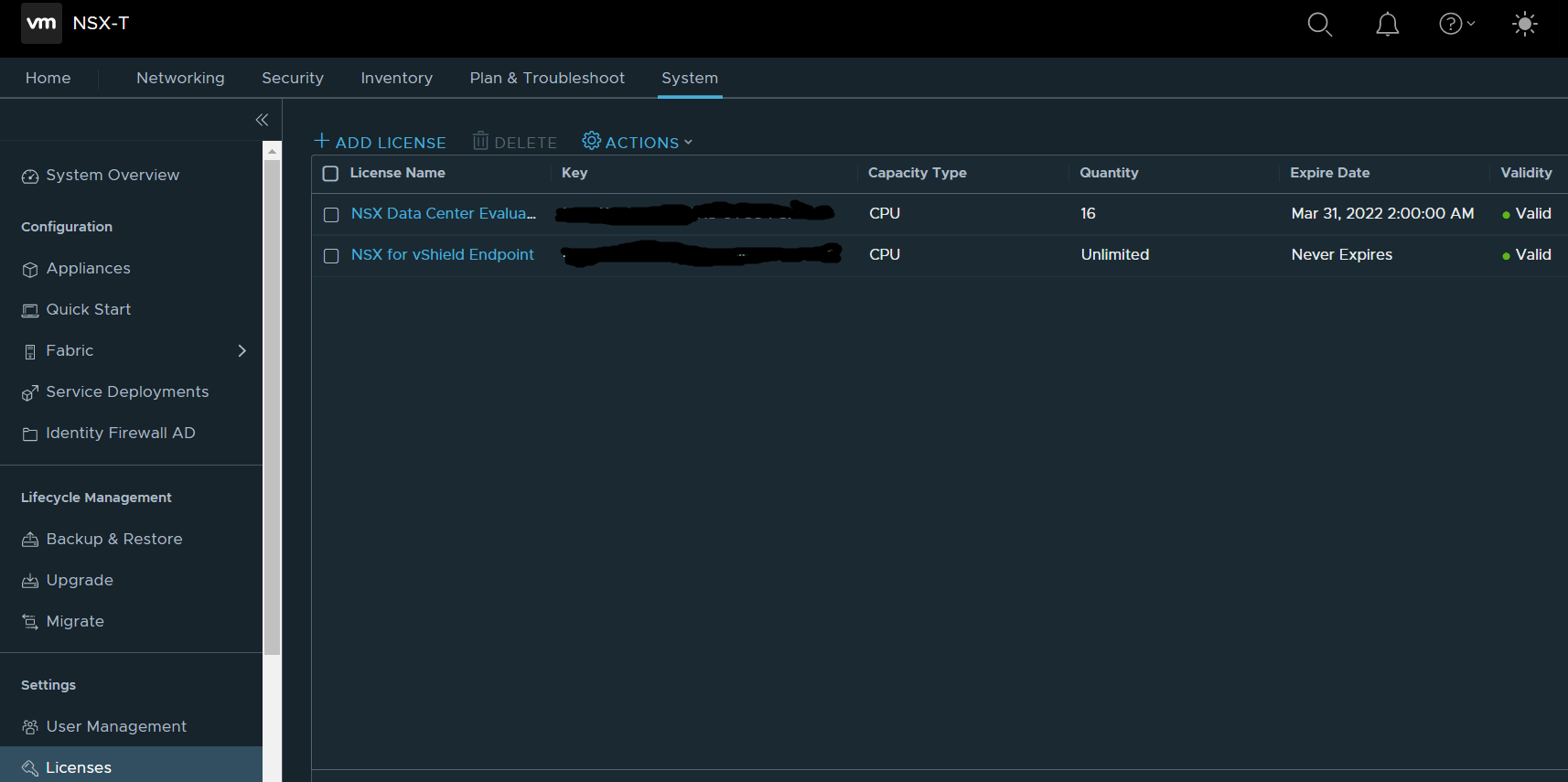

Per prima cosa applichiamo il tipo di licenza da utilizzare, per il laboratorio ho utilizzato la Enterprise con 1 mese di EVAL

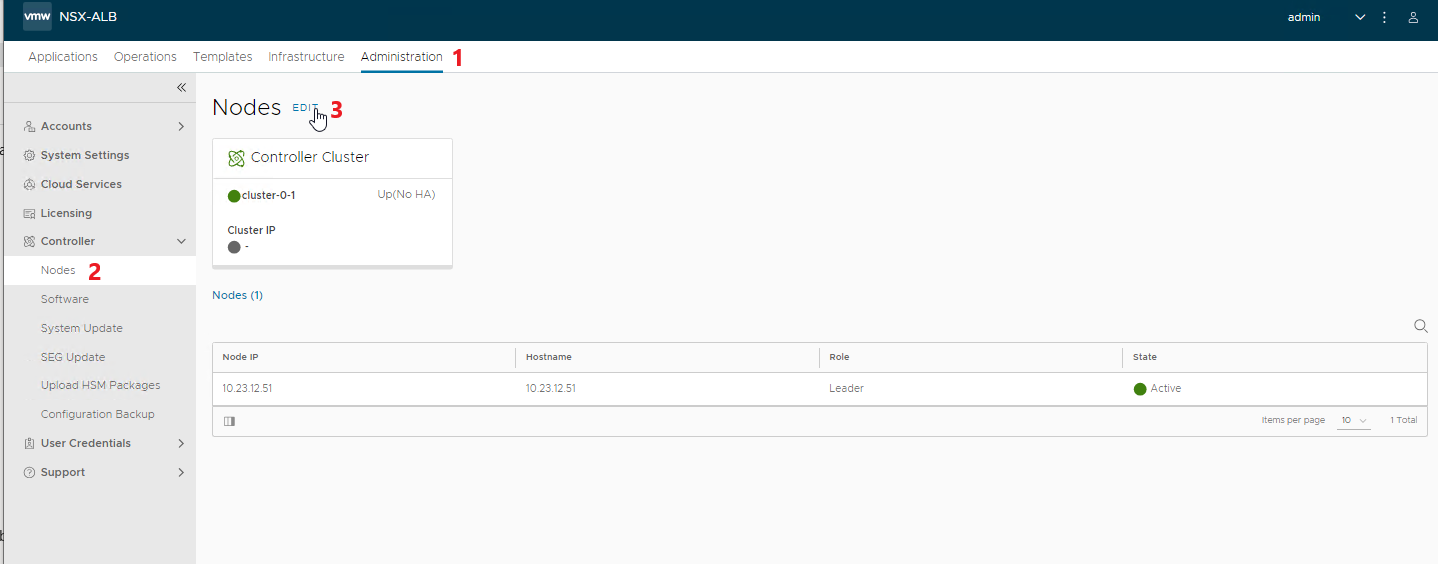

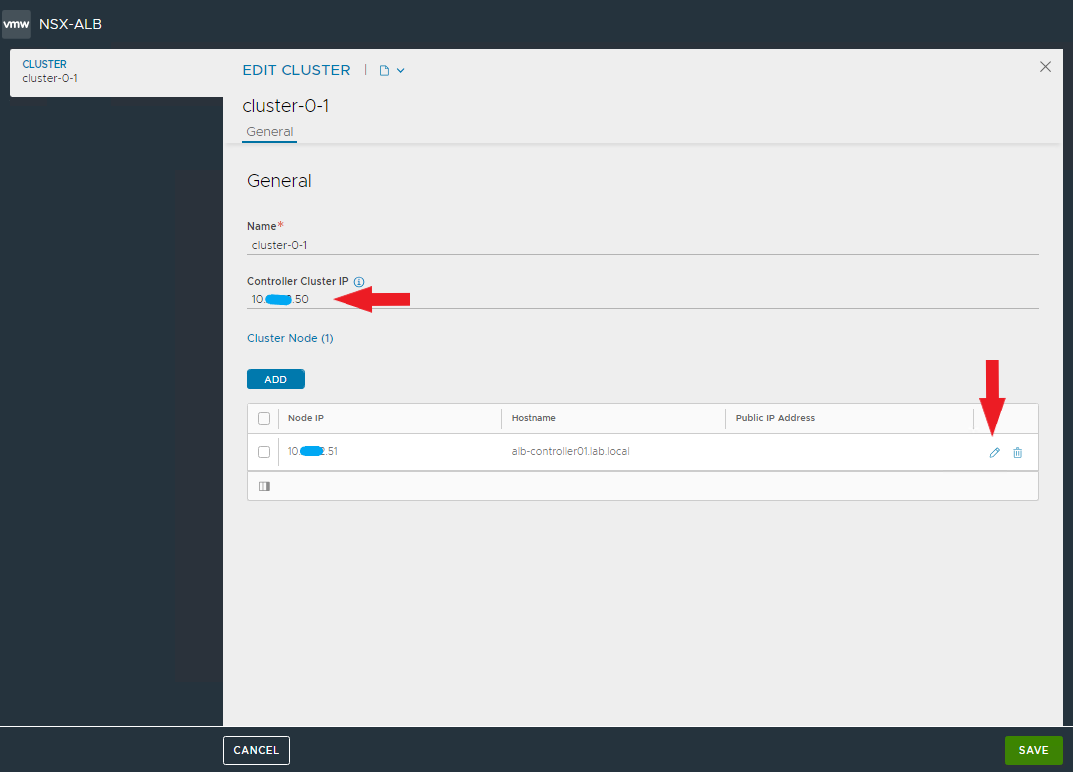

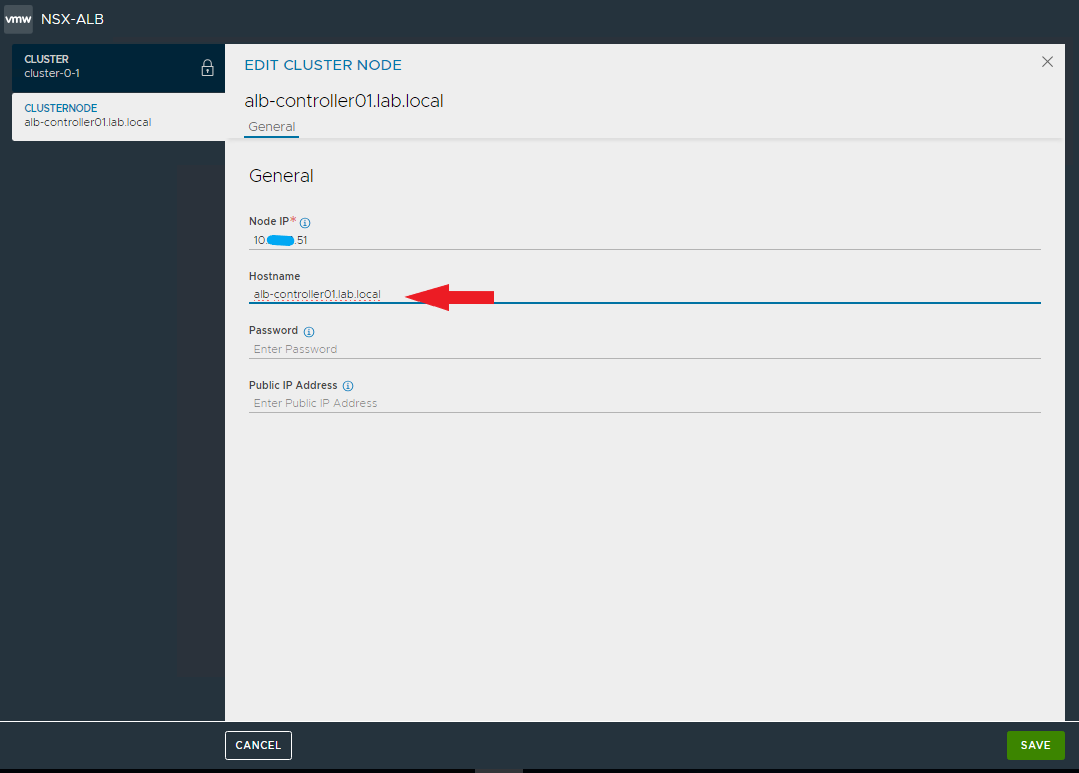

Andiamo a modificare le impostazioni del cluster e del nodo inserendo l’indirizzo virtuale e l’FQDN, dare SAVE.

NOTA: dopo aver salvato le impostazioni si perderà per qualche istante la connettività con il nodo

Ora sarà possibile collegarsi al controller attraverso il VIP impostato

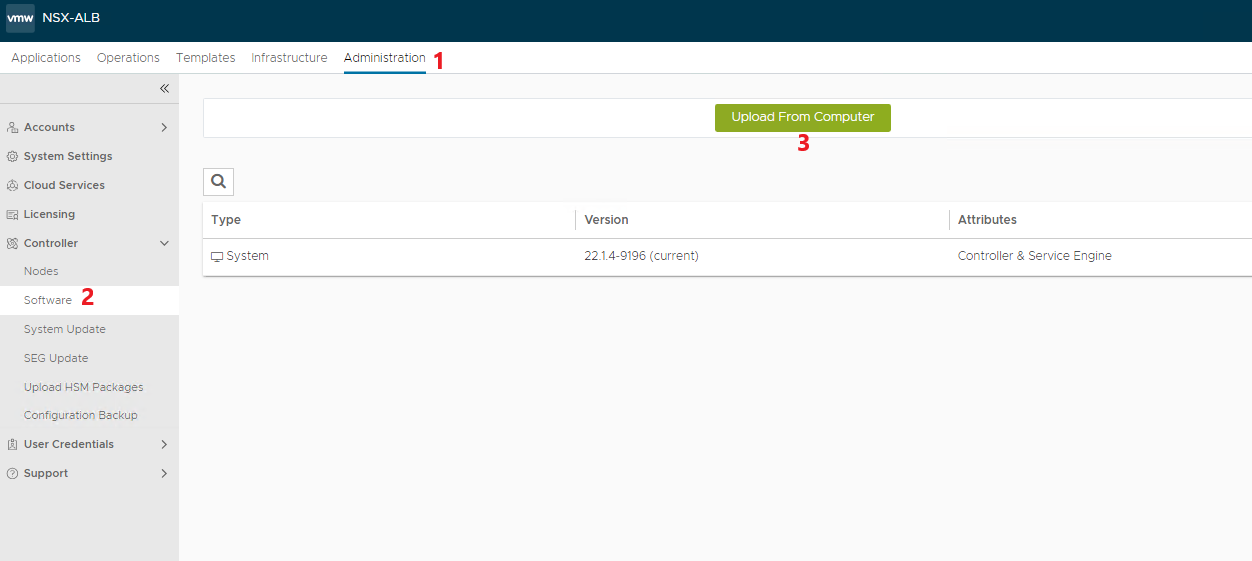

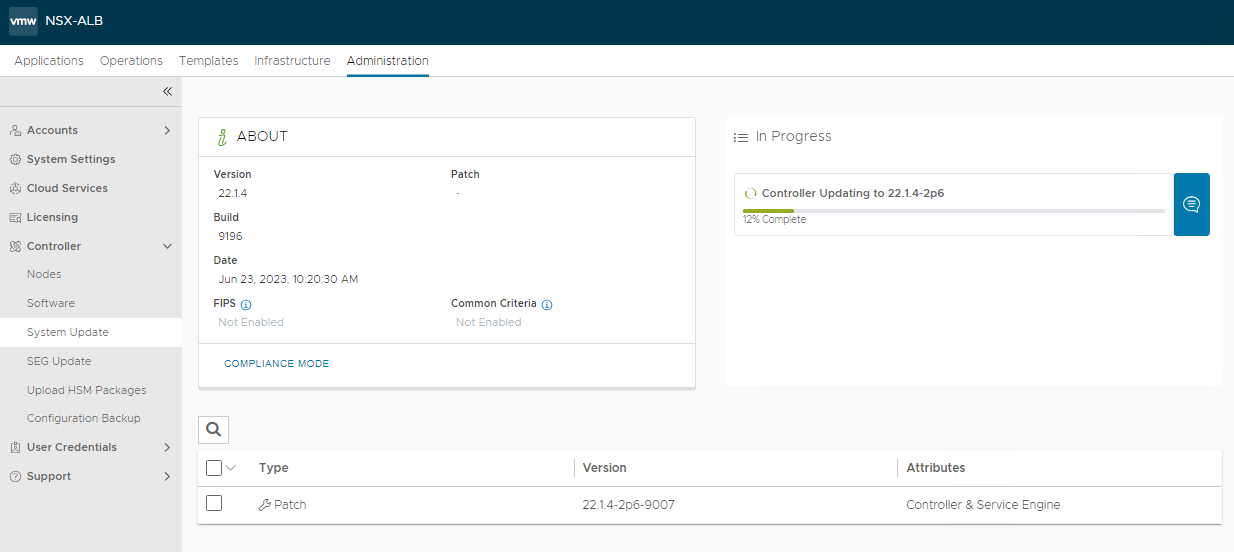

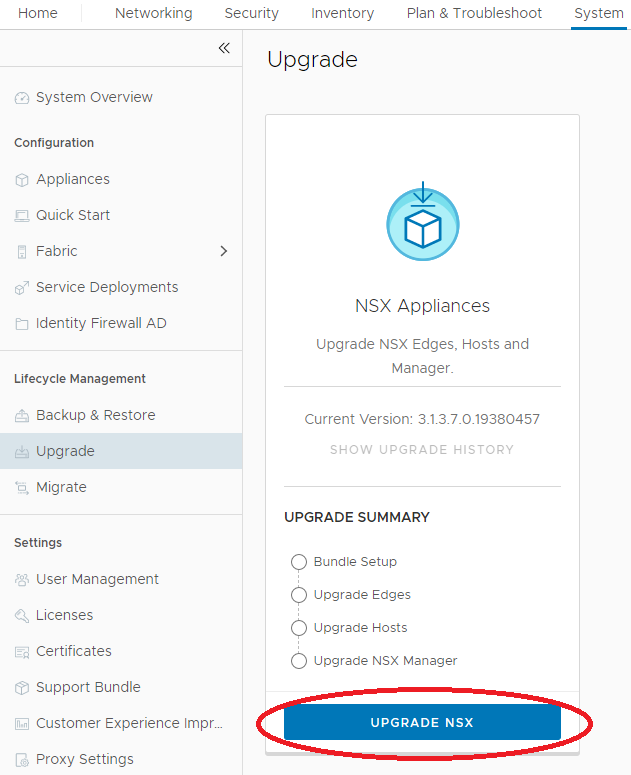

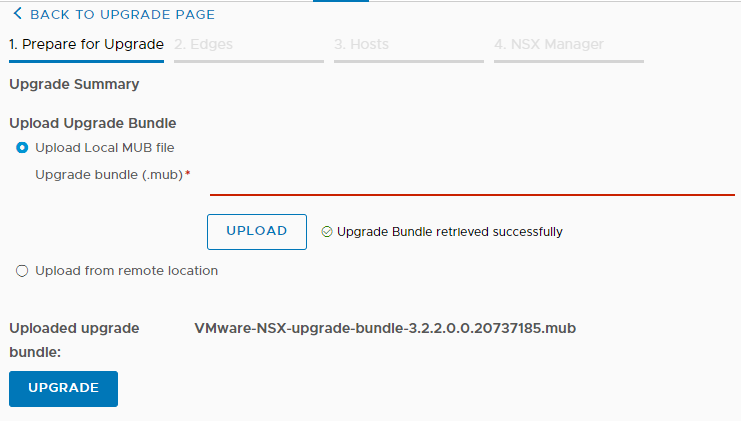

Applichiamo le utlime patch disponibili

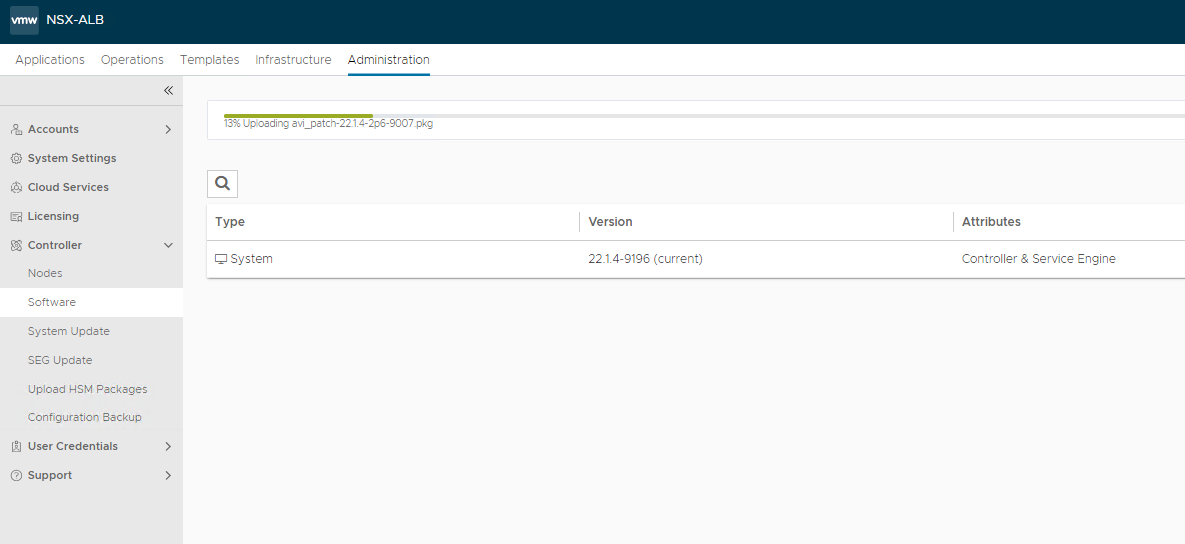

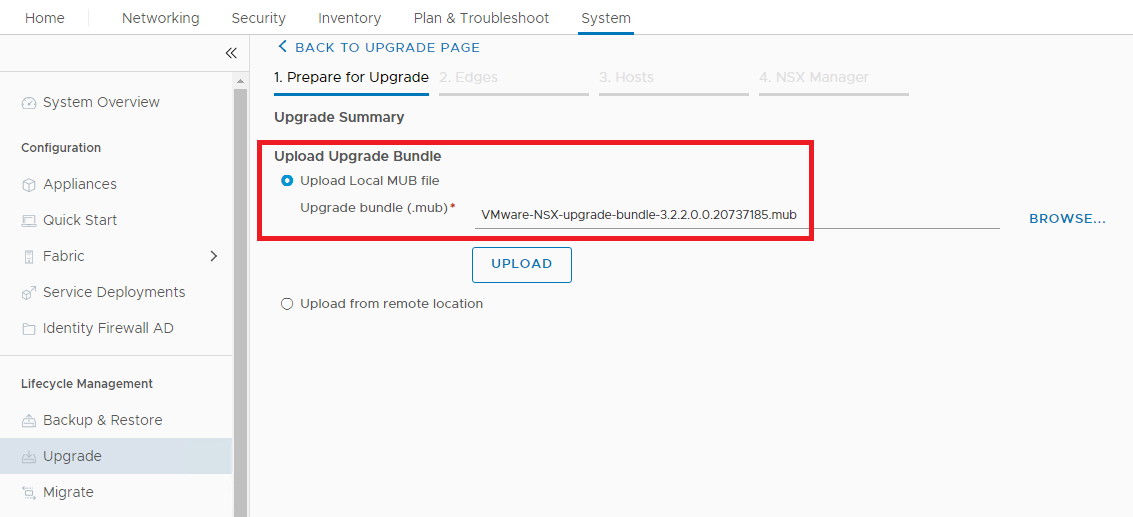

selezioniamo il file precedentemente scaricato e carichiamolo

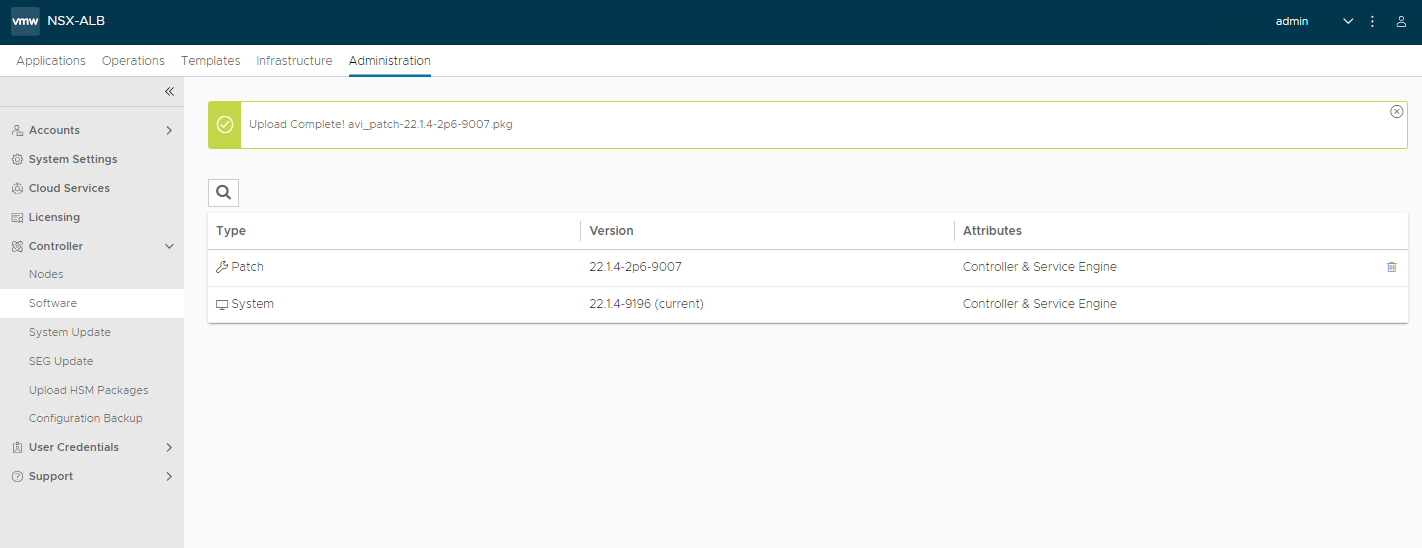

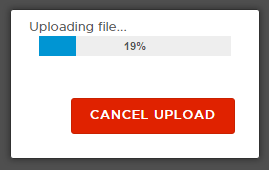

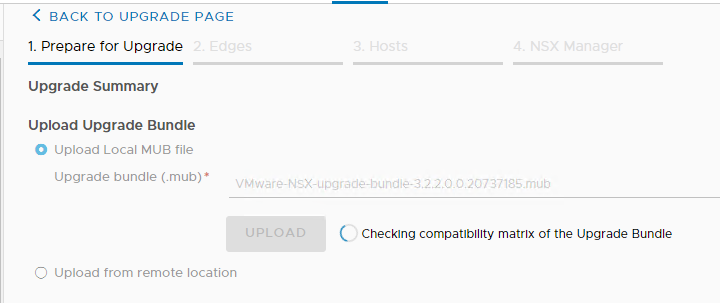

Attendiamo che l’upload si completi con successo

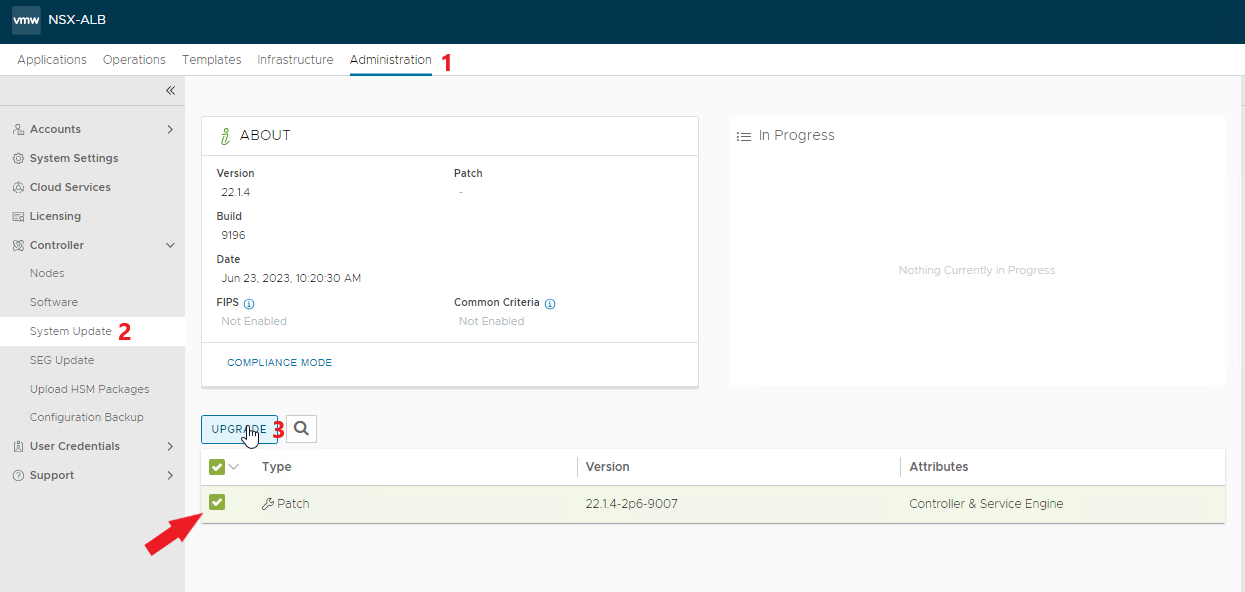

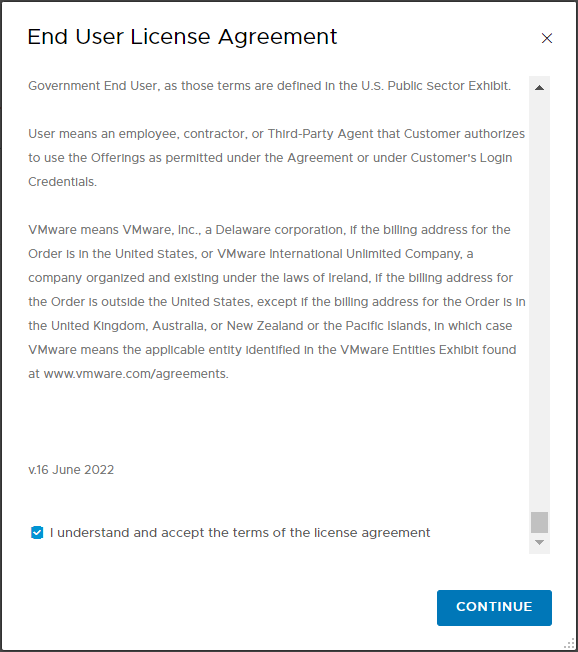

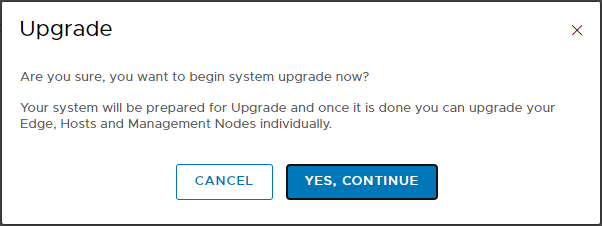

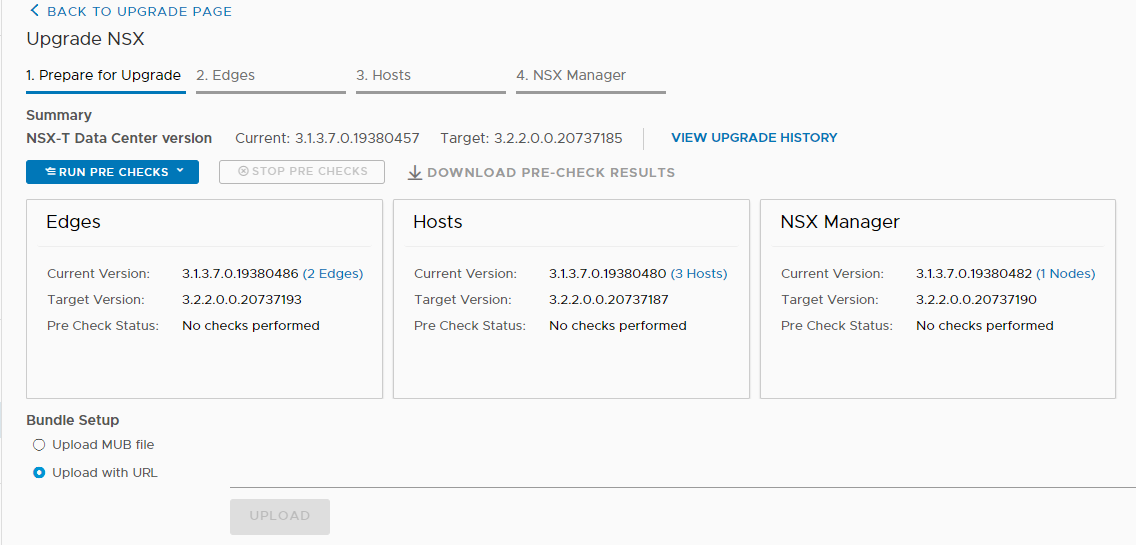

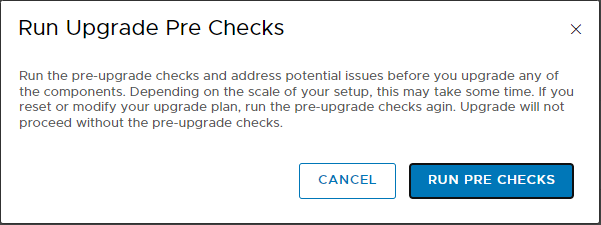

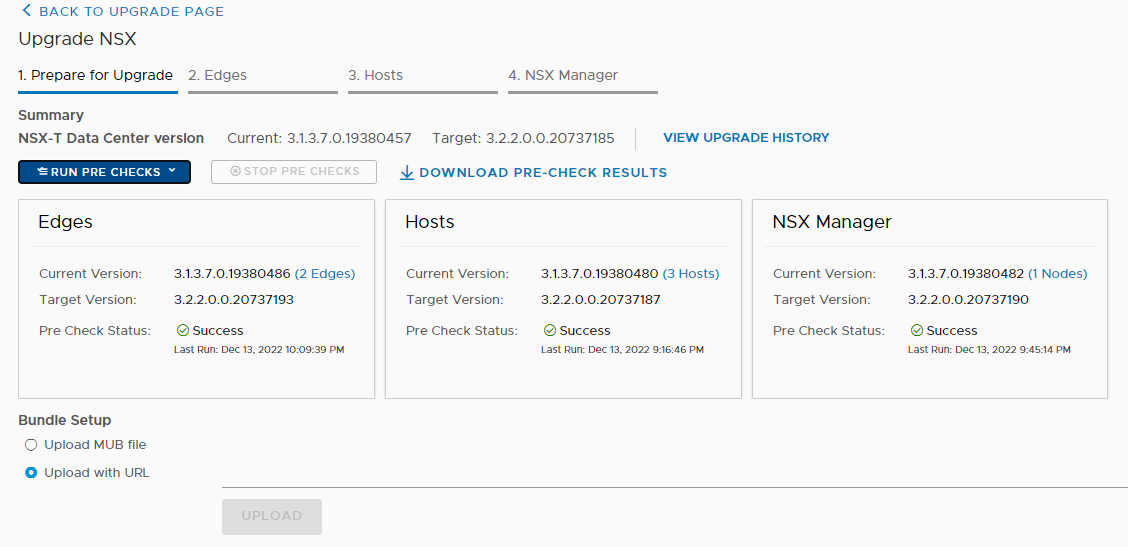

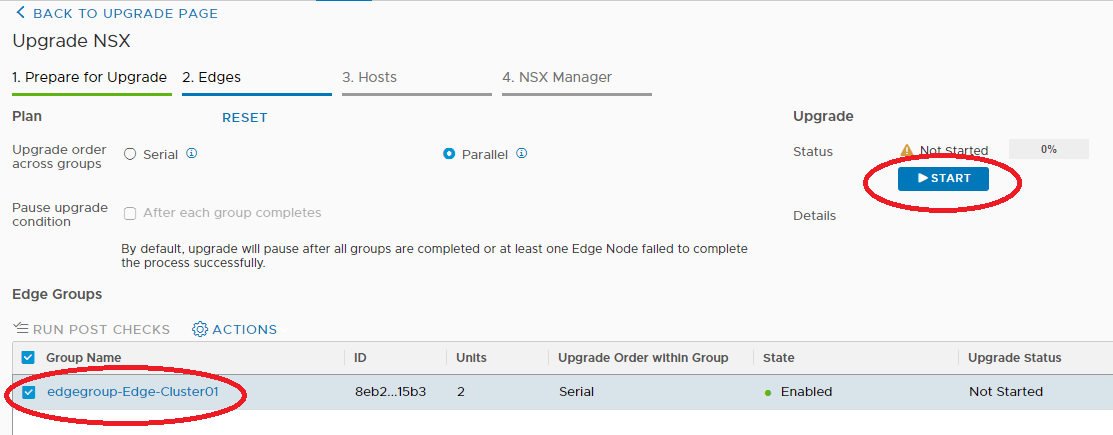

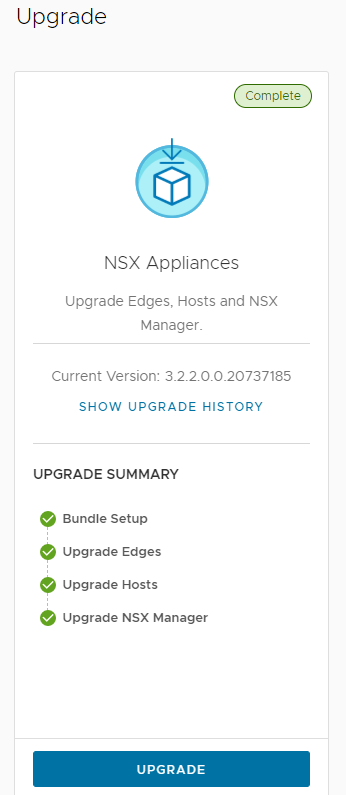

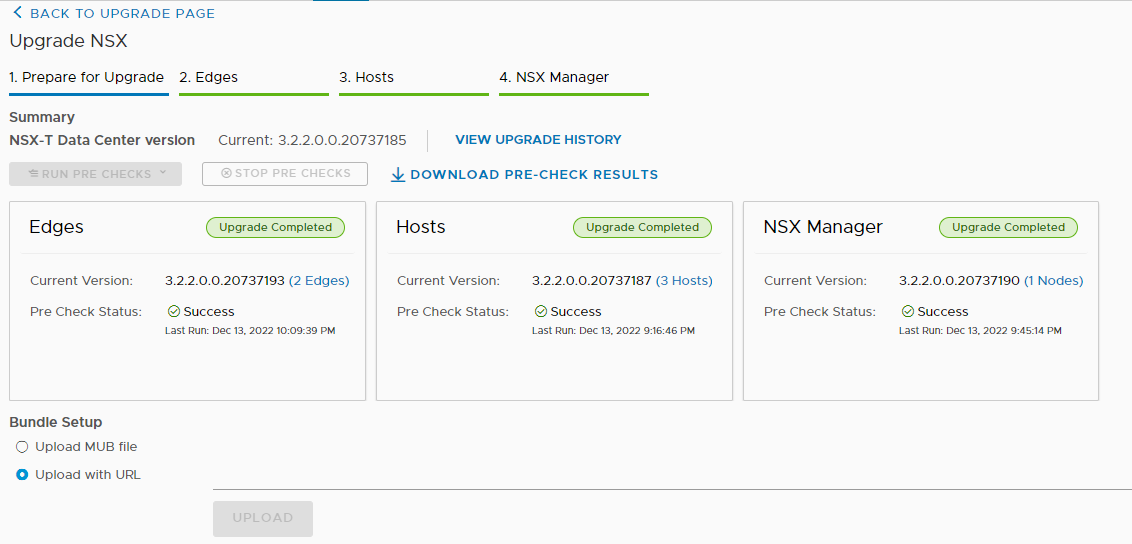

Eseguiamo l’upgrade

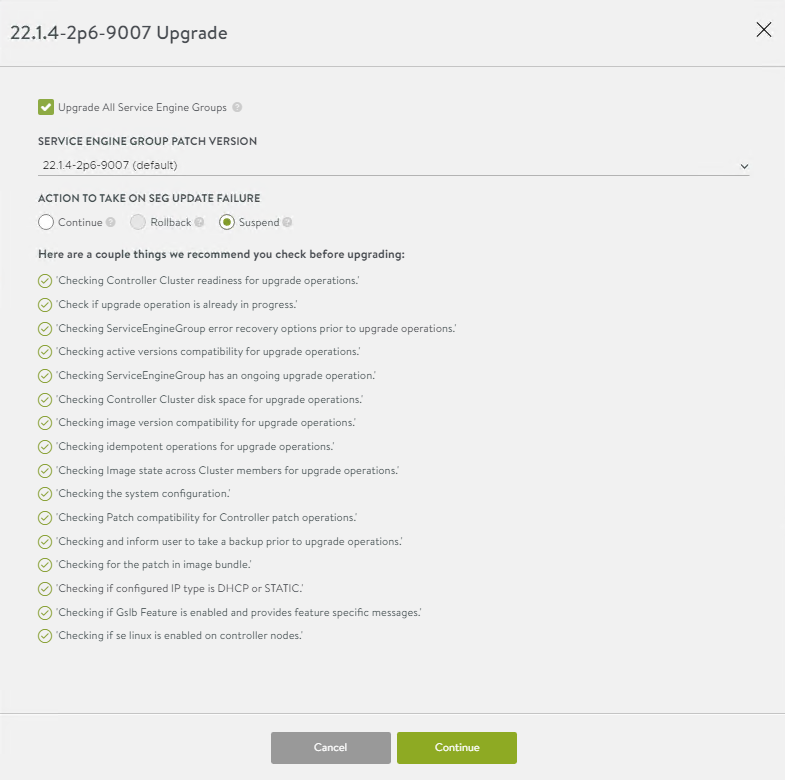

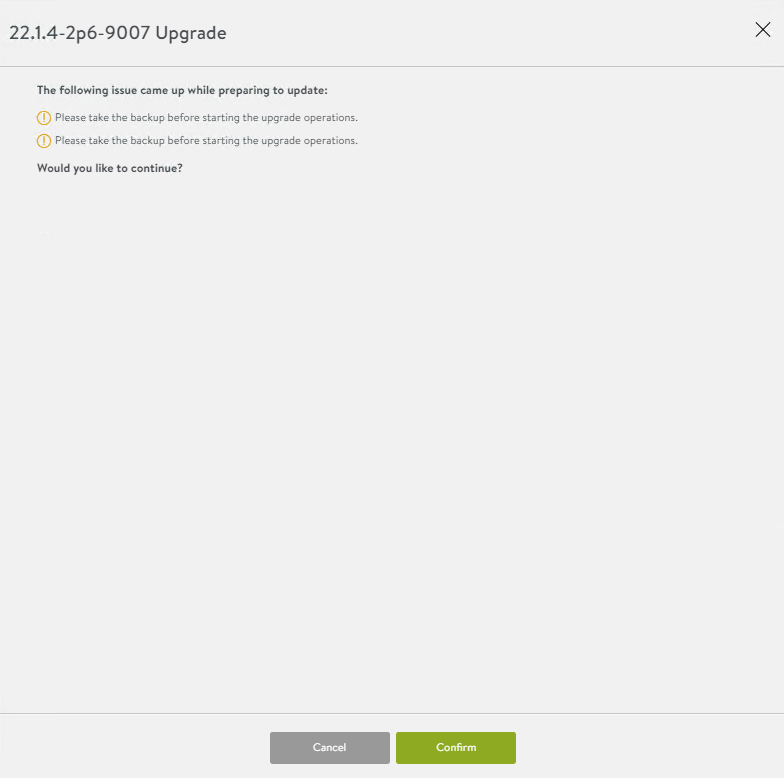

Lasciamo le impostazioni di default e diamo conferma

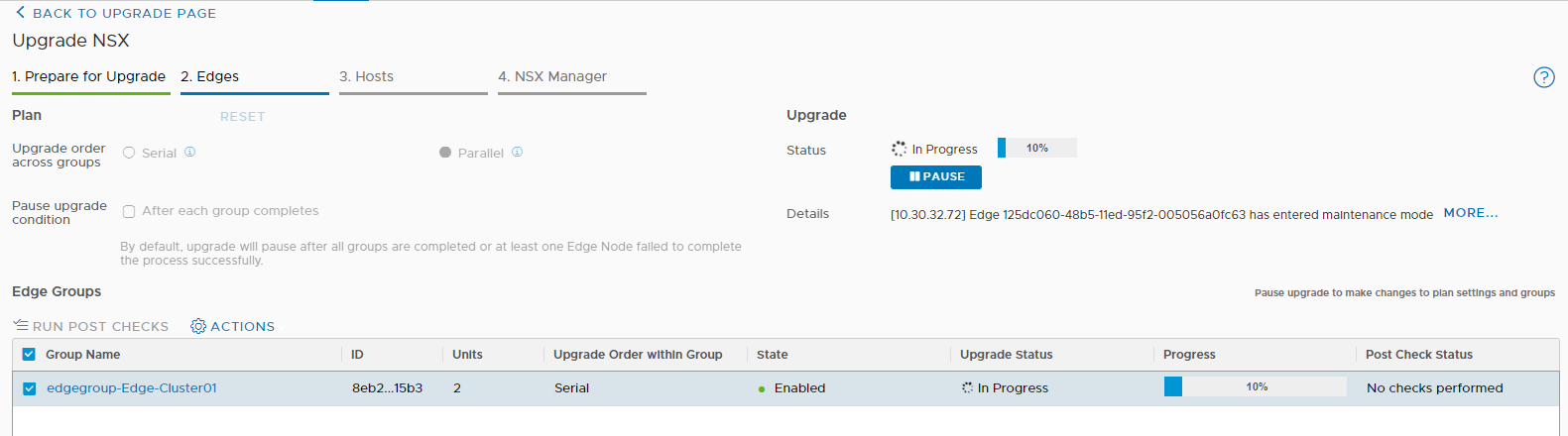

Seguiamo il processo di upgrade durante il quale il controller si riavvierà

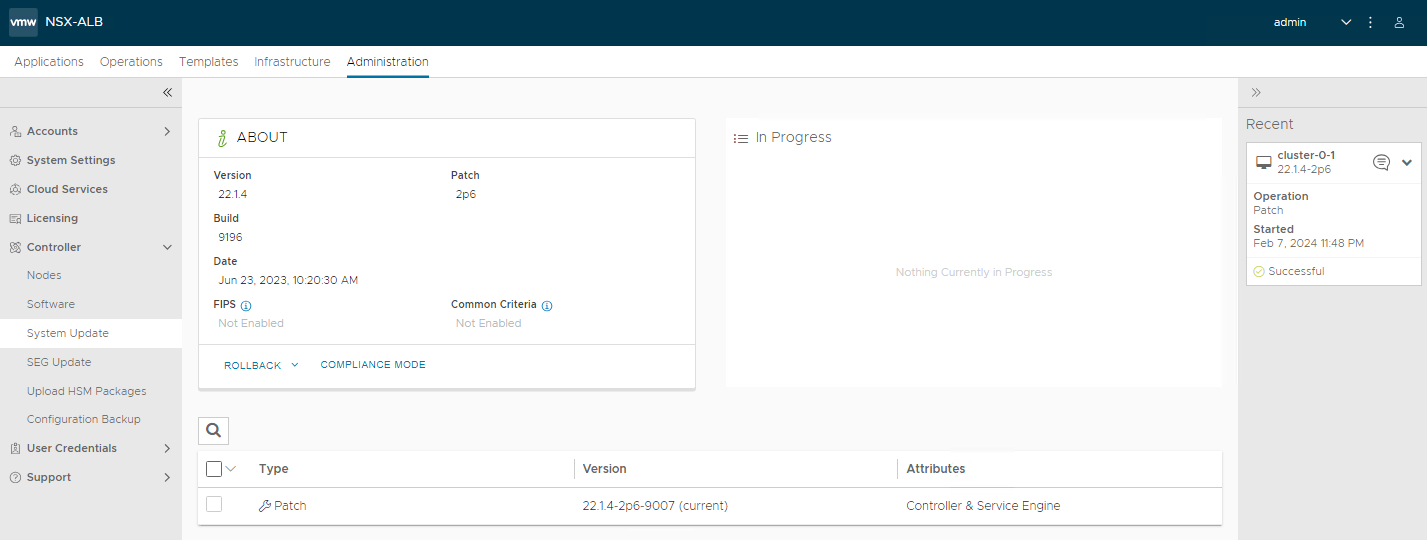

Alla fine vedremo la patch applicata

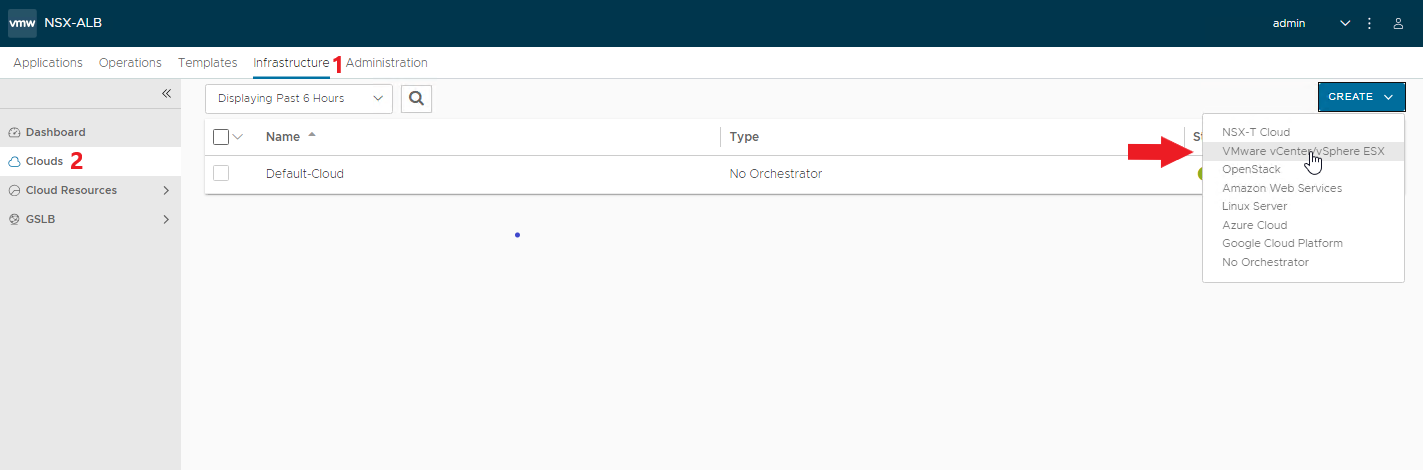

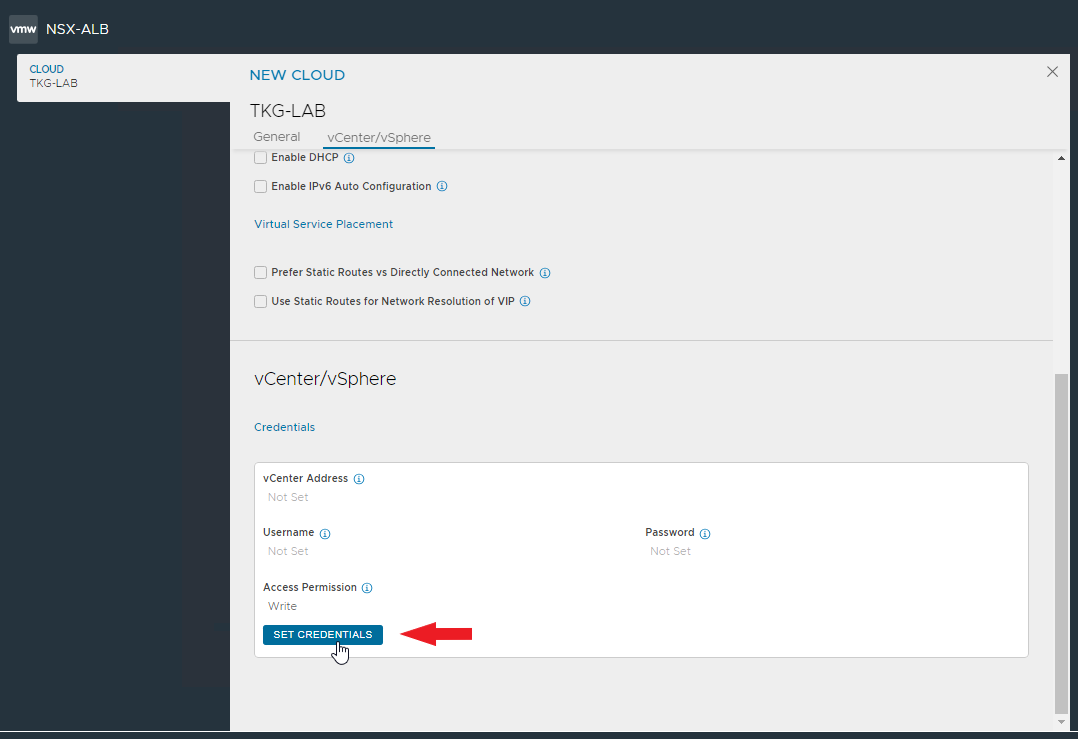

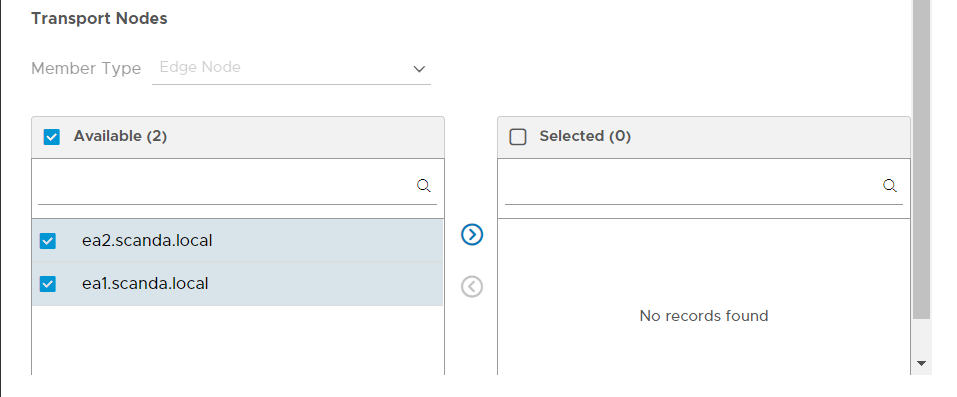

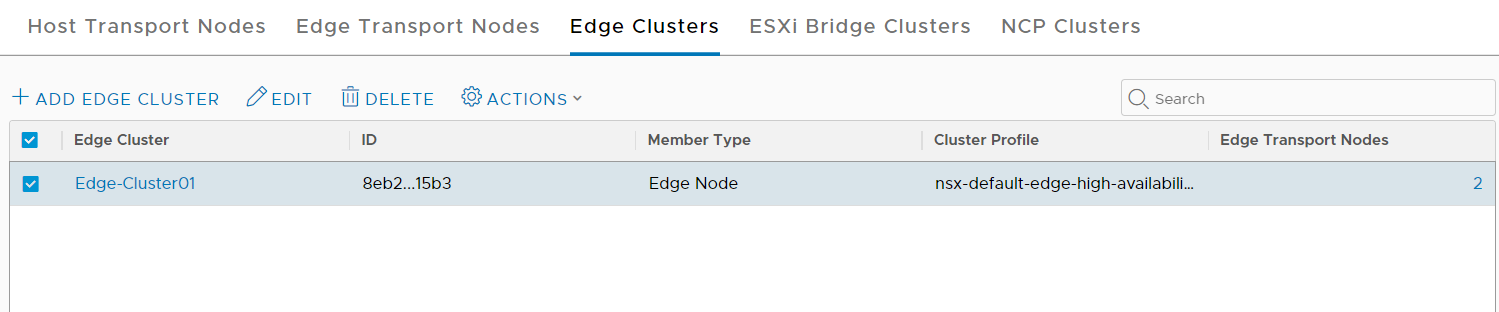

Creiamo ora la zona Cloud associata al nostro vCenter per il deploy automatico dei Service Engine

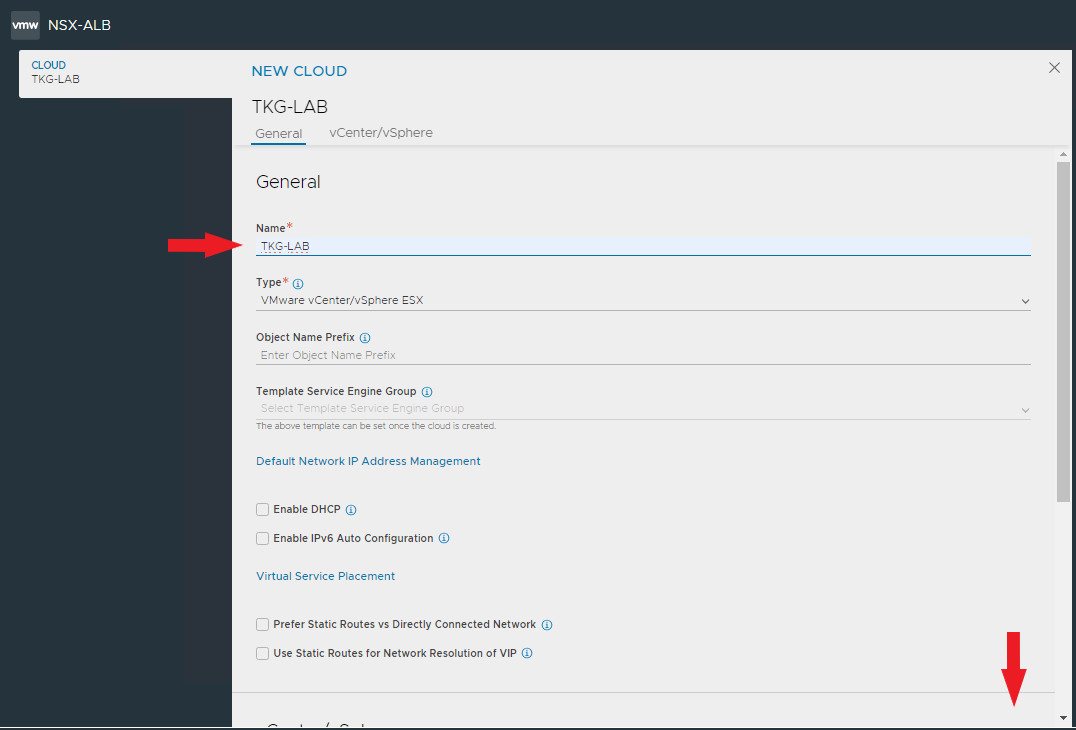

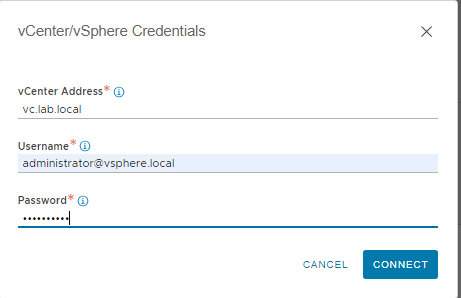

Inseriamo il nome Cloud e poi inseriamo i dati di collegamento al vcenter

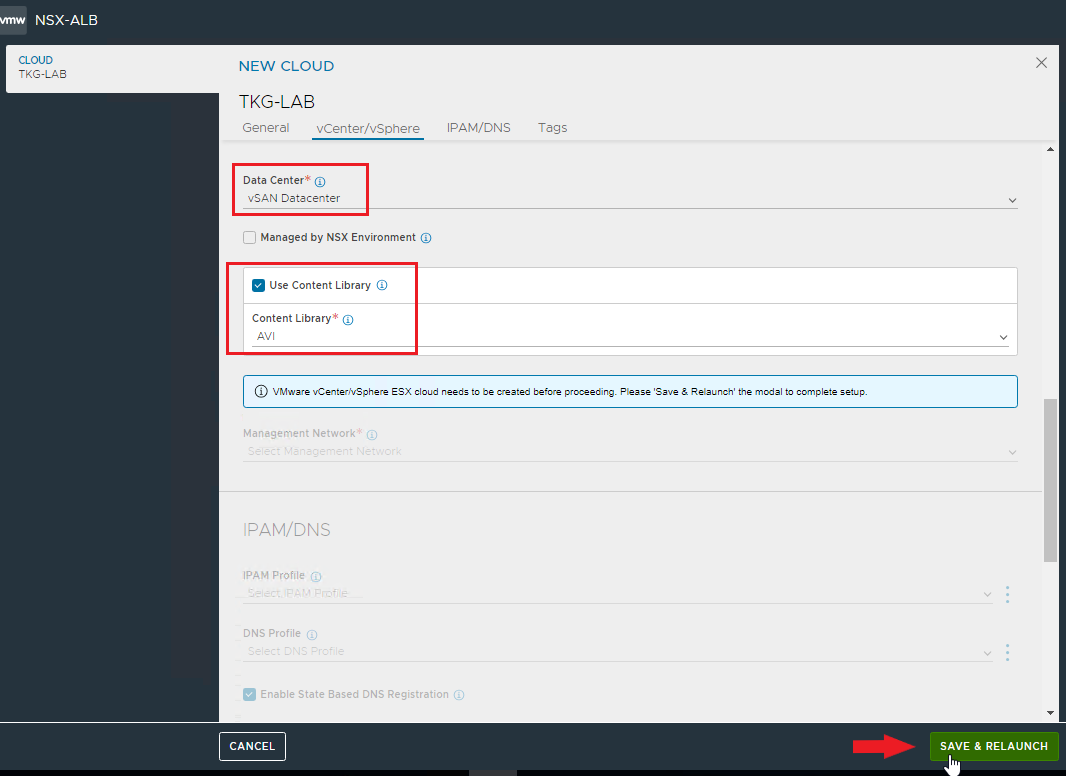

selezionare il Datacenter, l’eventuale Content Library e dare SAVE & RELAUNCH

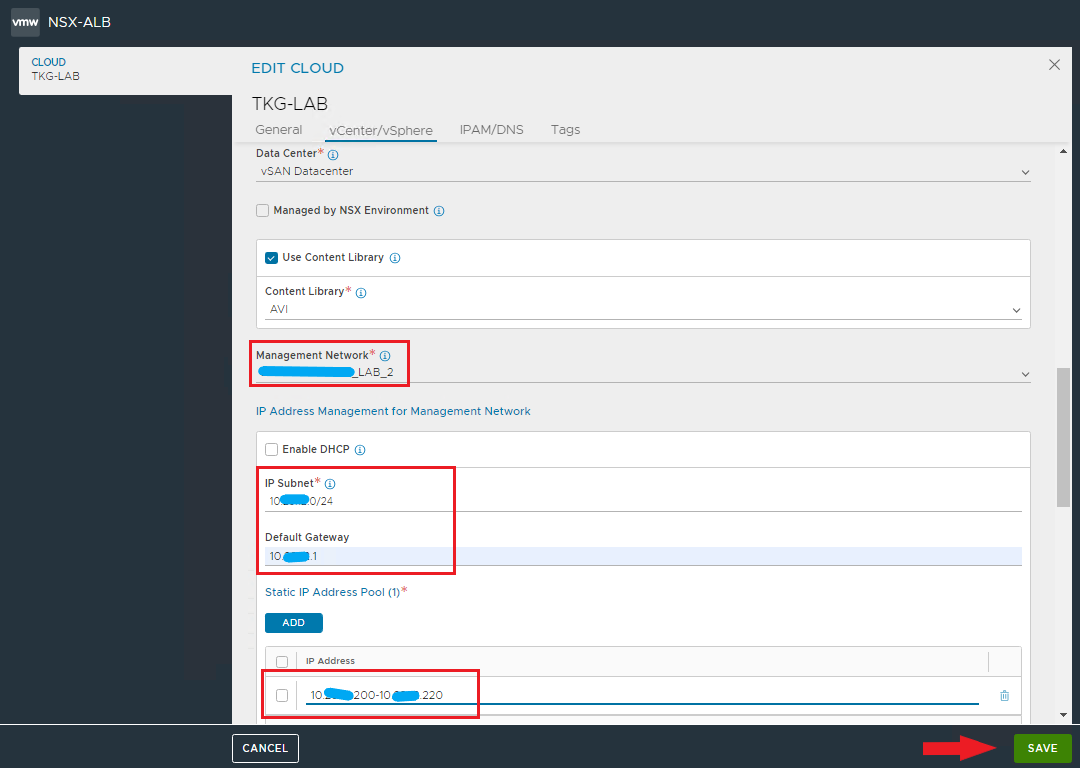

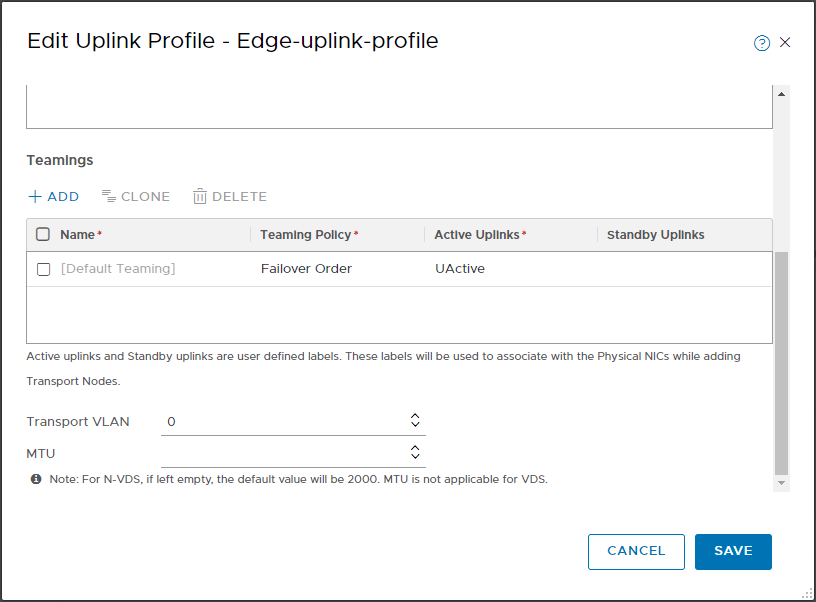

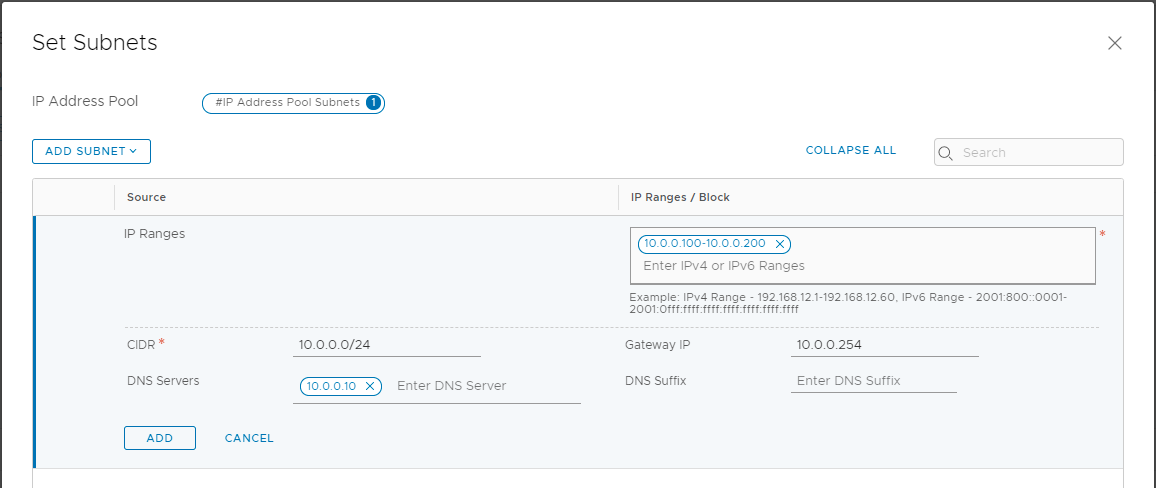

Selezionare la network di management, subnet, defaut GW e specificare il pool per l’assegnazione degli ip statici ai Service Engine

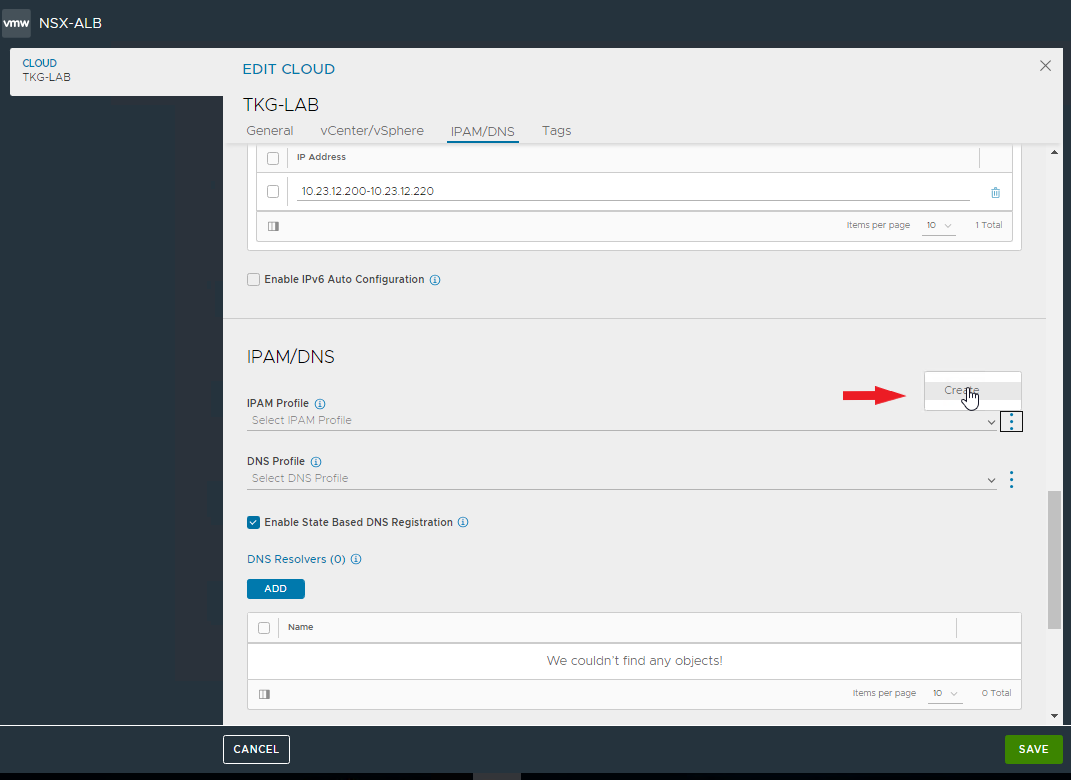

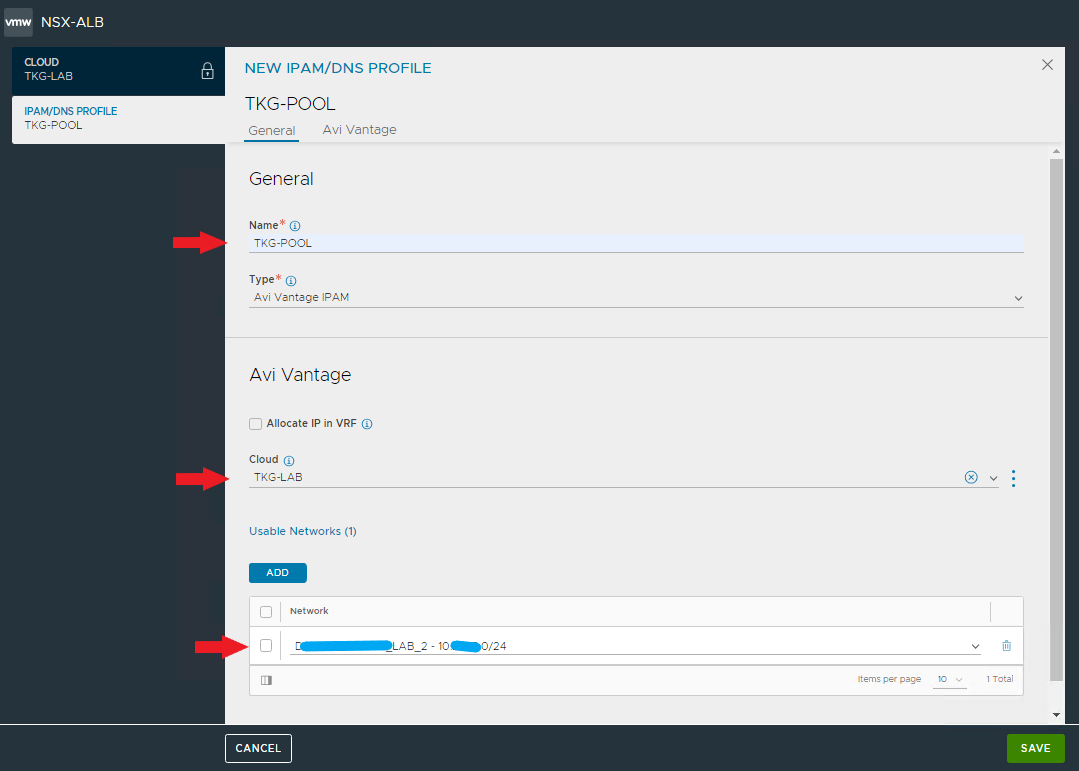

Creaiamo ora il profilo IPAM che verrà utilizzato per i VIP richiesti dai cluster Tanzu

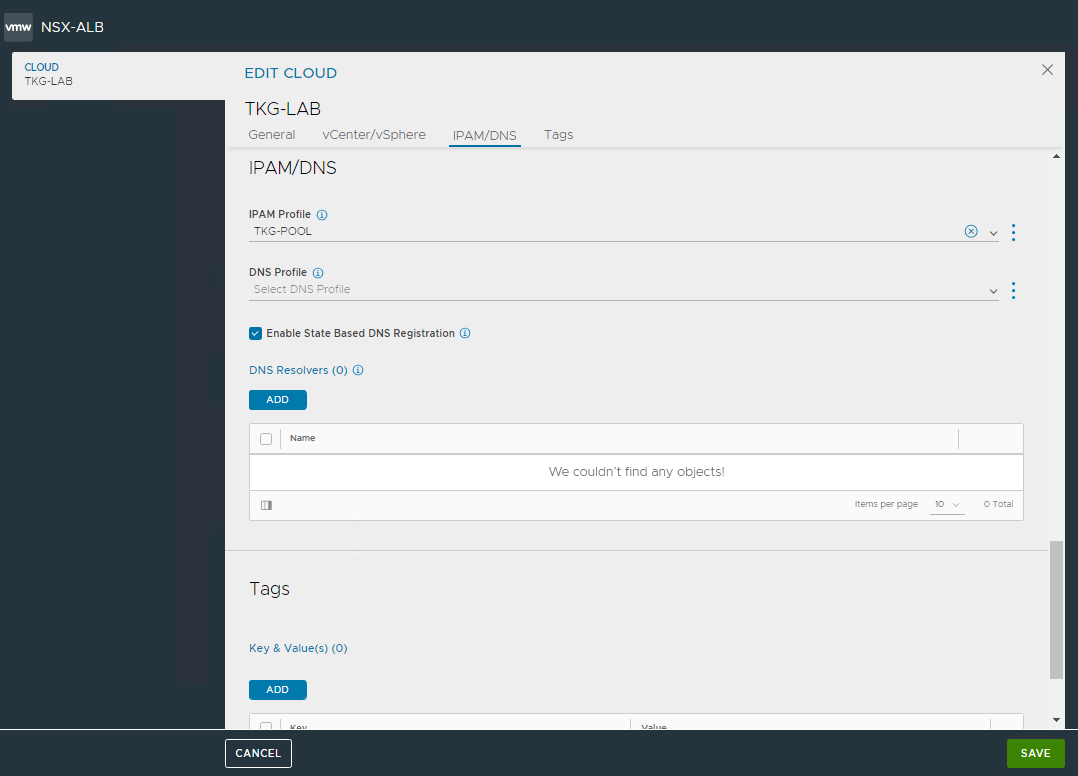

Salviamo e torniamo alla creazione della zona Cloud per dare anche qui conferma della creazione.

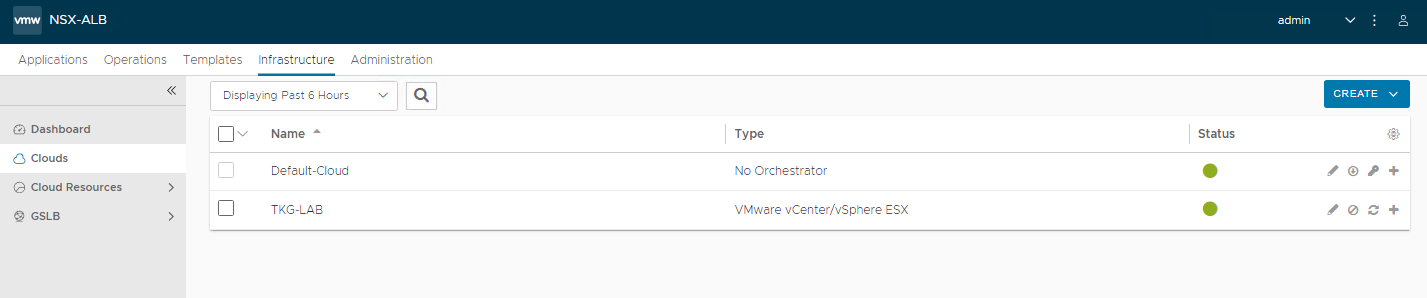

La nuova zona Cloud appare nell’elenco, verificate che sia online (pallino verde)

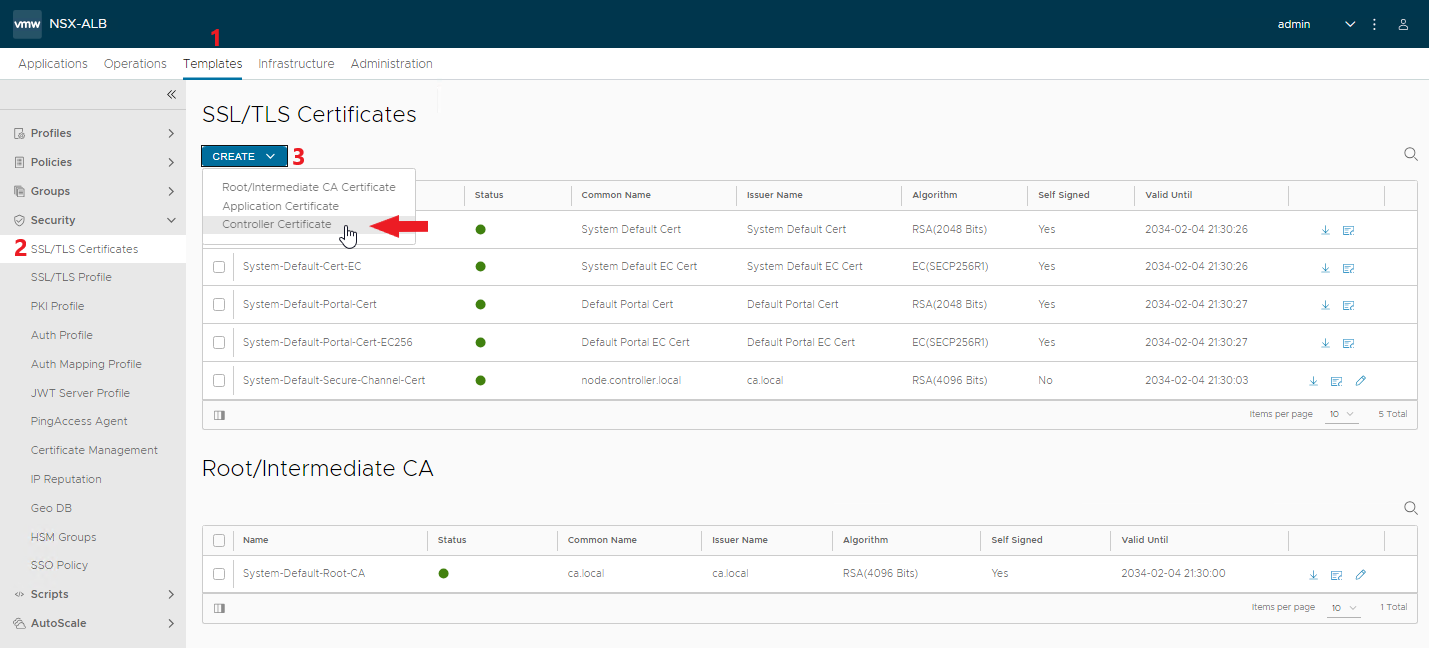

Generiamo ora un certificato SSL di tipo controller, è quello utilizzato nel wizard di creazione del cluster di management standalone di Tanzu

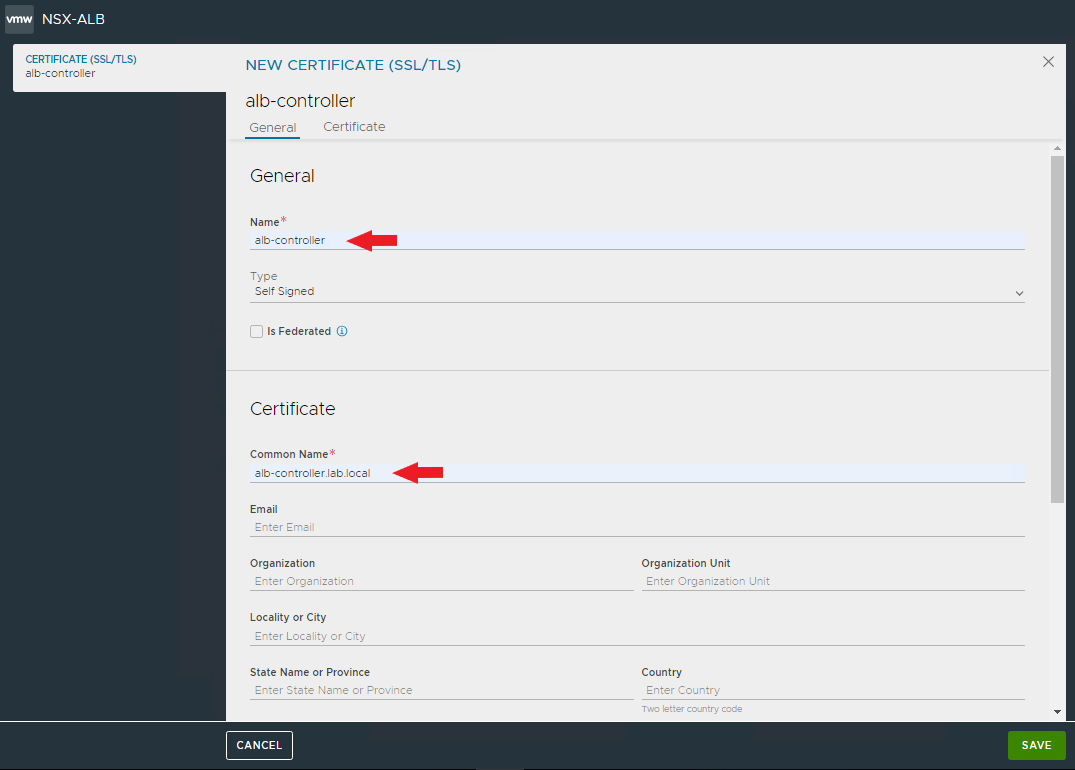

Sotto General inseriamo il nome e il Common Name del certificato, attenzione che rifletta l’effettivo record DNS (FQDN) utilizzato da Tanzu per accedere al controller AVI. Inserite tutti i campi necessari.

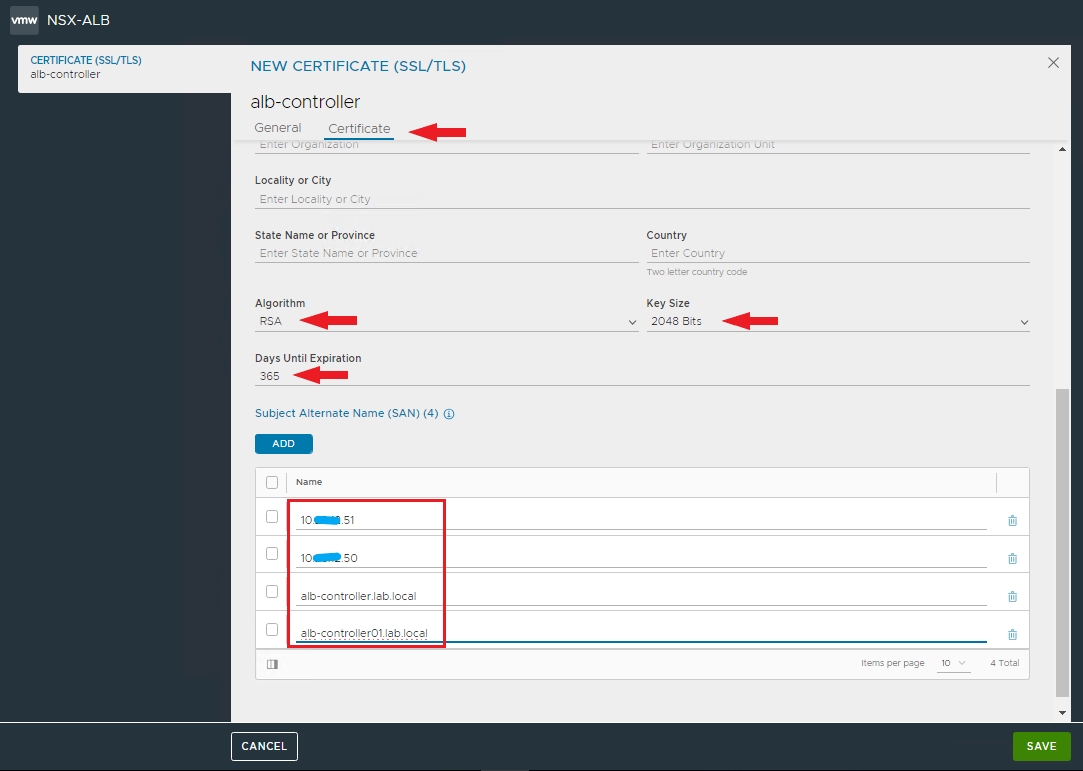

Completiamo il certificato con i giorni di validità (365 o più se volete) e inseriamo tutti i Subject Alternate Name con cui può essere invocato il certificato (IP address del VIP e dei controller, includiamo anche gli FQDN dei singoli controller)

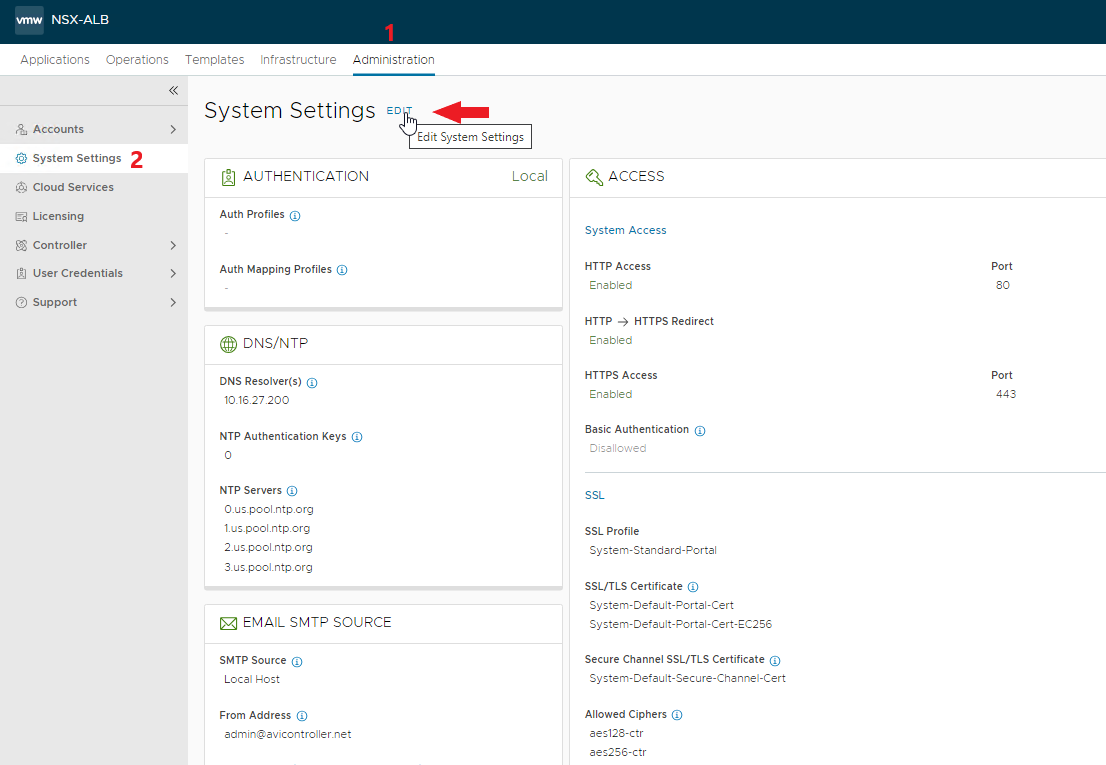

Il certificato andrà utilizzato per accedere al VIP del controller, andiamo ad impostarlo per l’accesso.

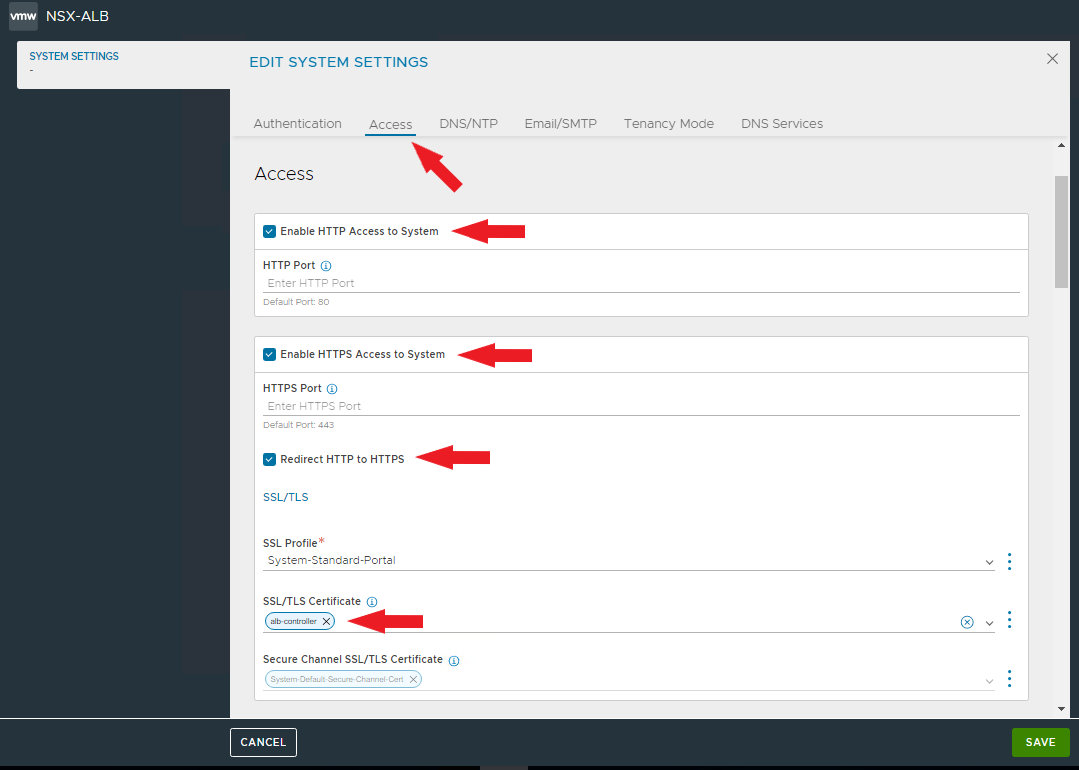

Abilitiamo l’accesso HTTP e HTTPS nonchè il redirect su HTTPS.

Eliminiamo gli attuali certificati e selezioniamo quello appena creato.

NOTA: confermato il nuovo certificato sarà necessario ricollegarsi al controller

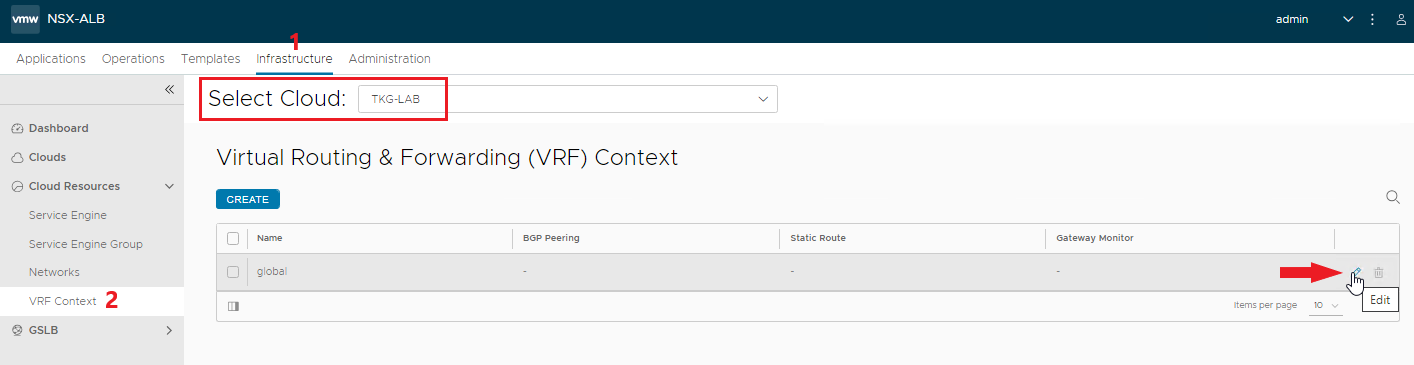

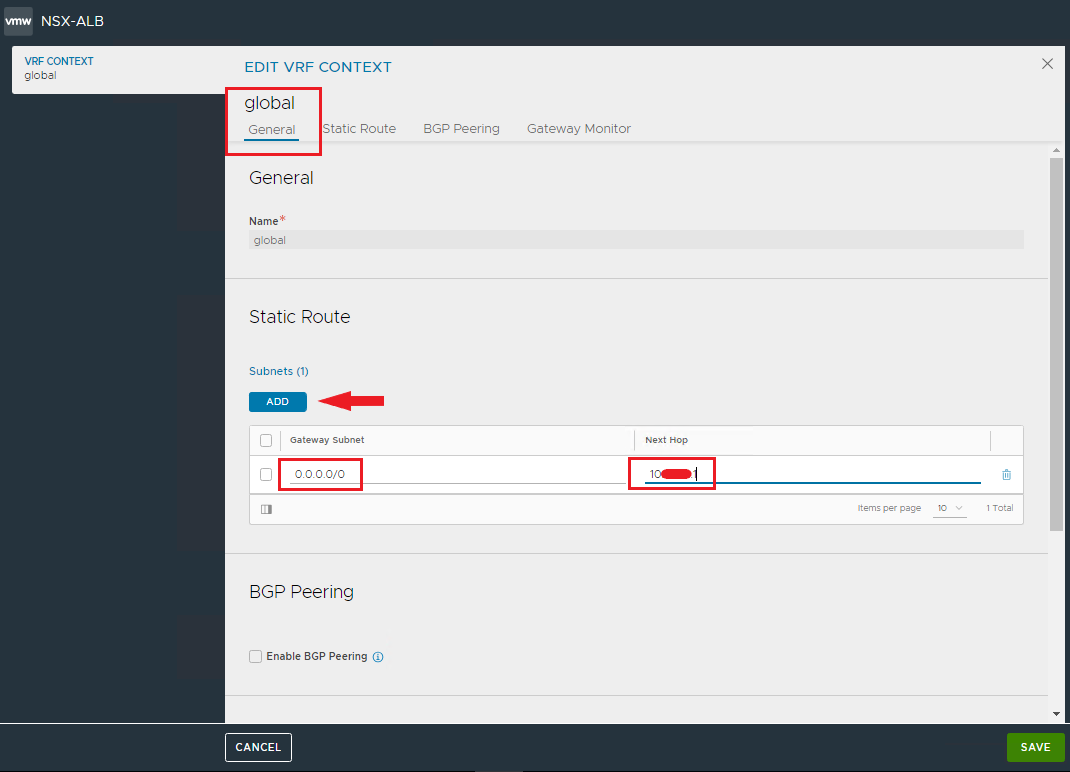

Rimane da inserire la rotta di default per il traffico in uscita dalla VRF associata alla nostra zona Cloud.

NOTA: verifichiamo sia selezionata la nostra zona Cloud nel campo Select Cloud

Inseriamo il default GW per tutto il traffico in uscita

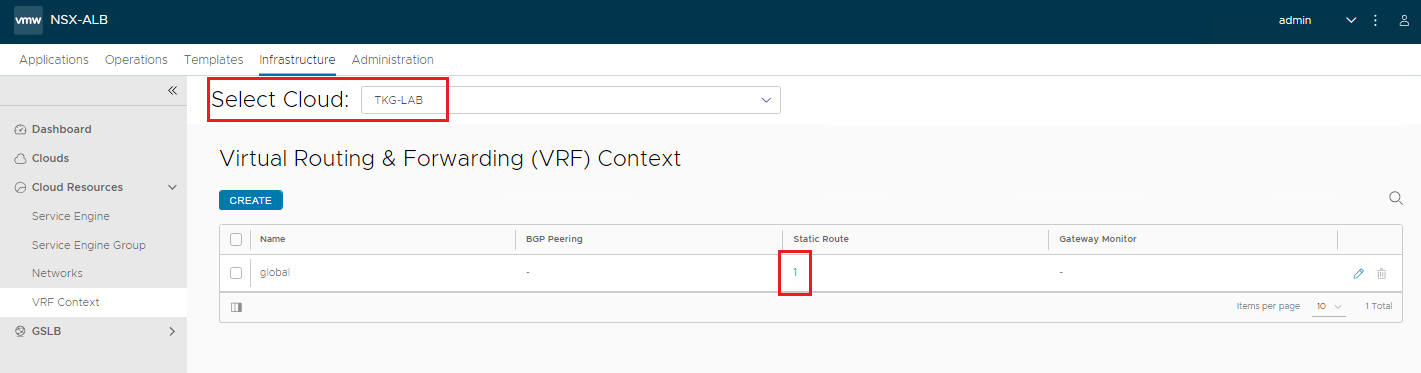

Verifichiamo che sia presente la rotta

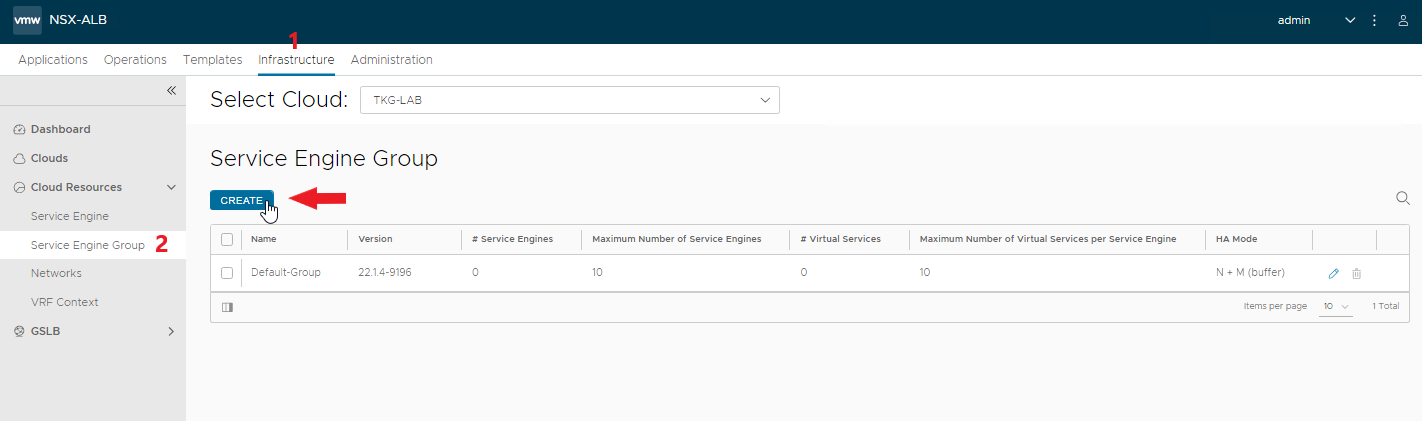

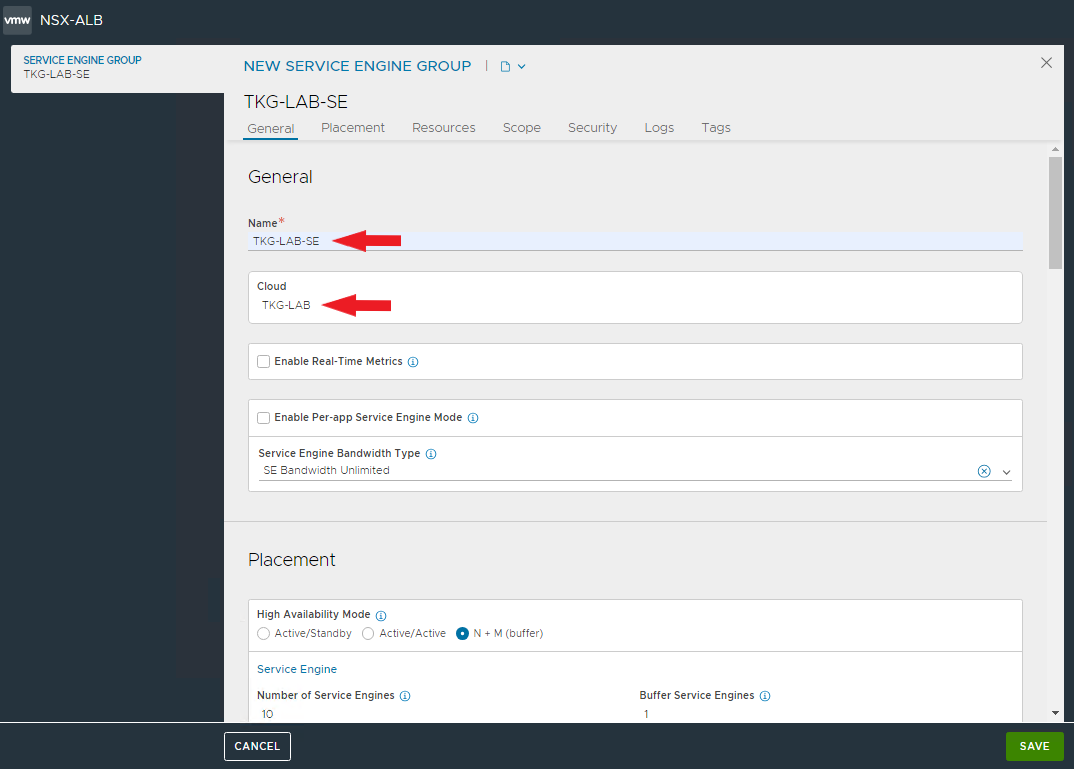

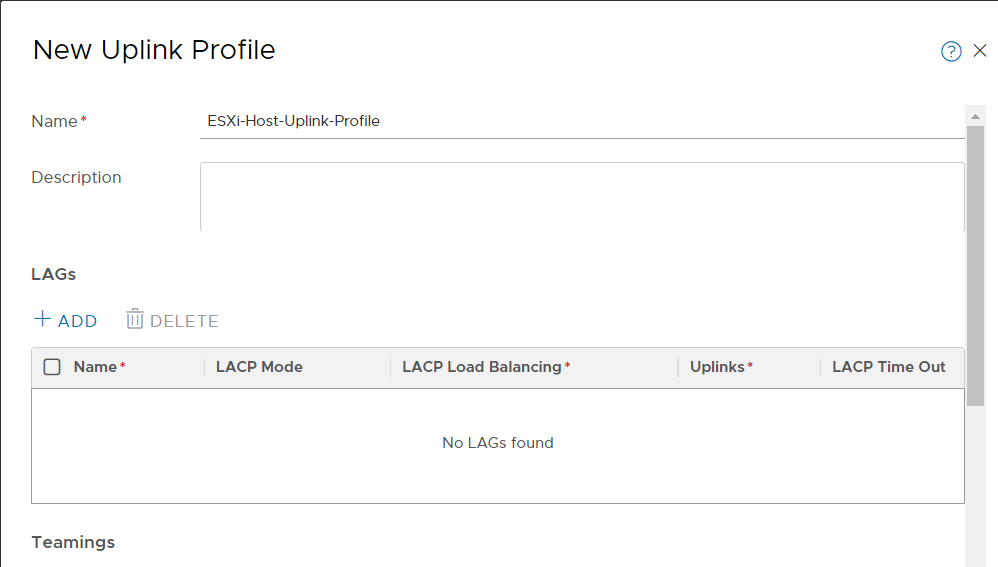

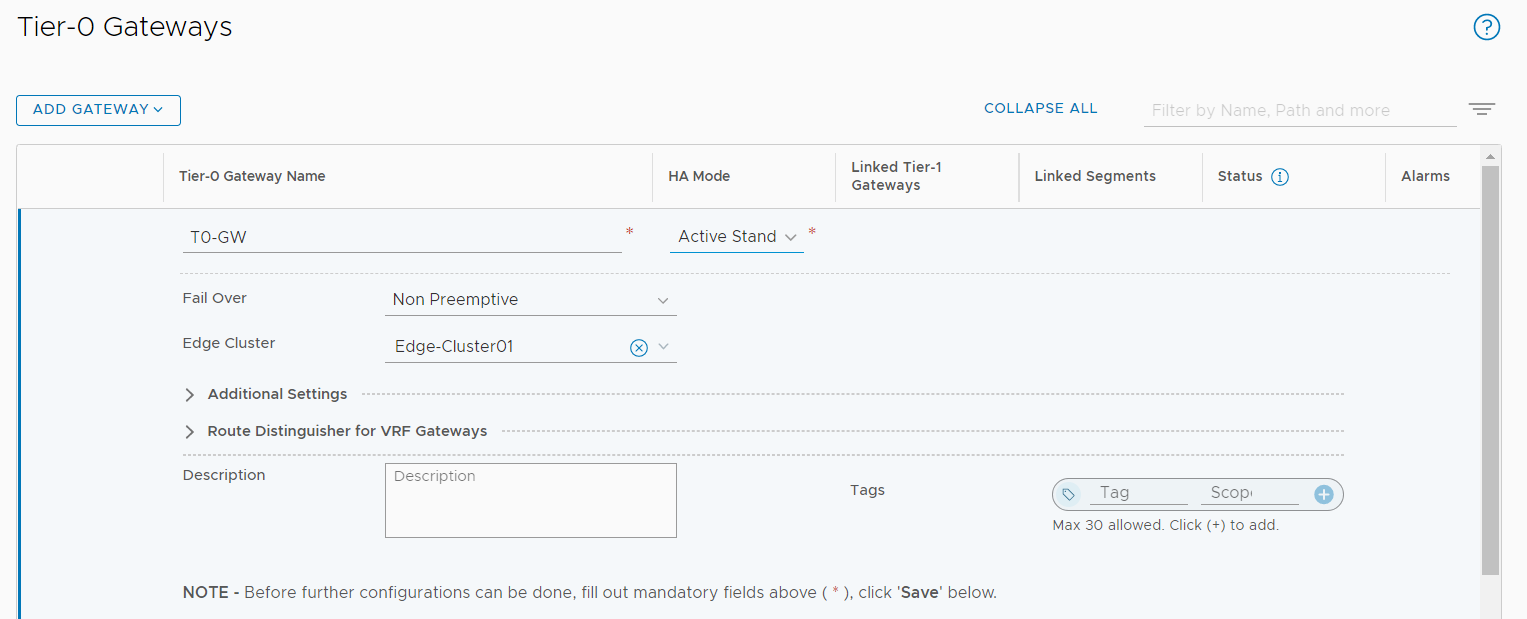

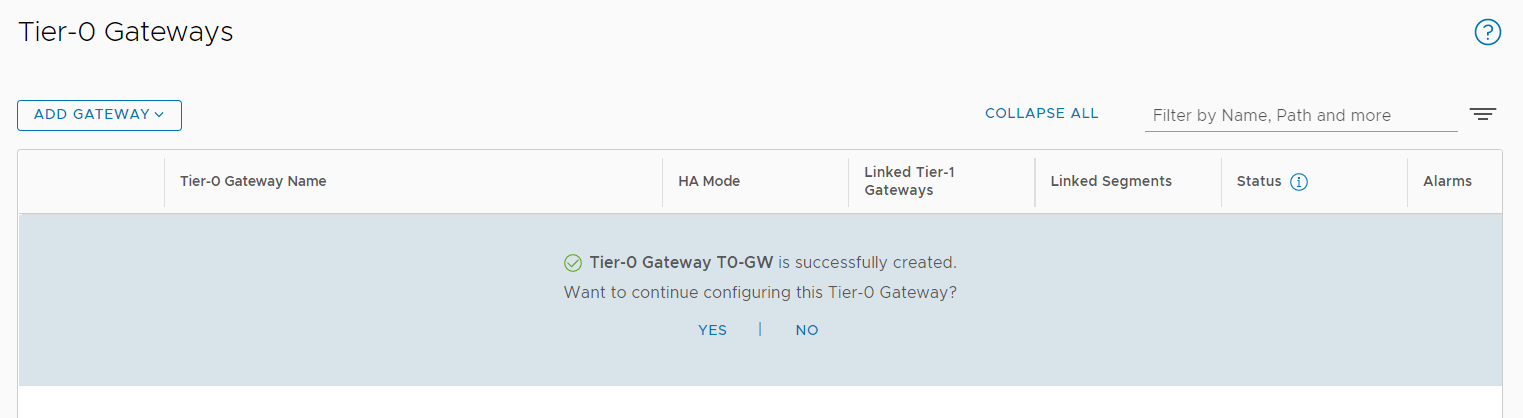

Completiamo la nostra configurazione creando un Service Engine Group da utilizzare per Tanzu. Questo ci permetterà di personalizzare le configurazioni degli SE utilizzati per Tanzu.

Inseriamo il nome e selezioniamo la nostra zona cloud.

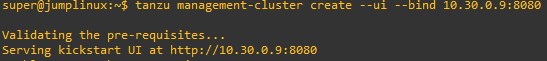

Ora abbiamo un bilanciatore ALB pronto per servire i nostri cluster Tanzu 🙂